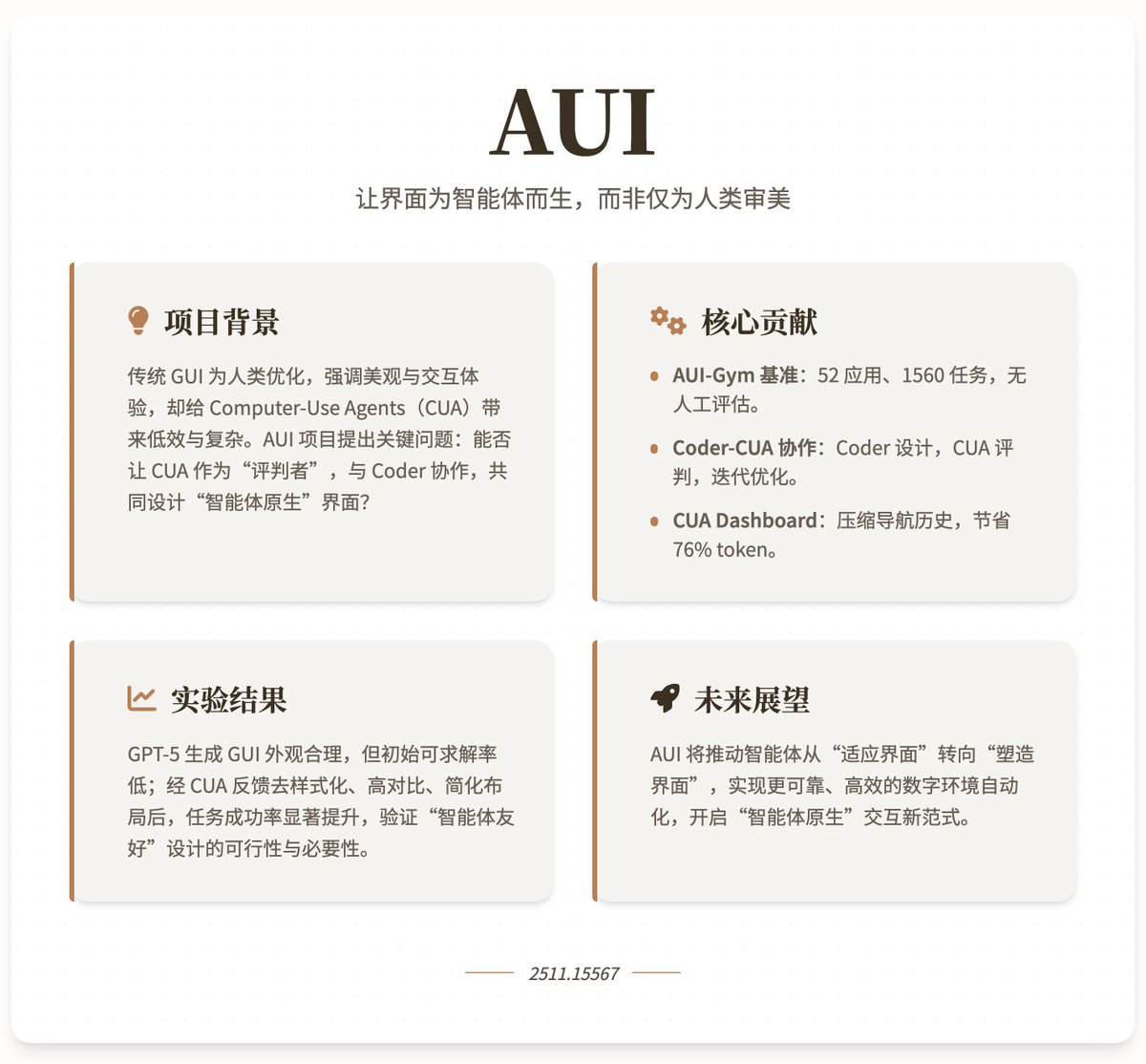

Avec Gemini 3.0 Pro et Claude Opus 4.5 qui continuent d'améliorer leurs capacités de génération d'interface utilisateur, y a-t-il encore un avenir pour les développeurs front-end ? 😂 Je plaisante 😄 Les modèles d'IA sont si performants pour générer des interfaces utilisateur qu'ils sont très conviviaux, mais les interfaces utilisateur qu'ils génèrent sont-elles conviviales pour les agents d'IA ? Les dernières recherches, « AUI », menées par l'Université d'Oxford, l'Université nationale de Singapour et Microsoft, explorent comment utiliser des agents d'utilisation informatique (CUA) et des modèles de langage de programmation pour générer et optimiser automatiquement des interfaces graphiques, rendant ainsi l'interface plus adaptée aux agents intelligents qu'aux humains. Contexte et motivation du projet : Les interfaces graphiques traditionnelles sont principalement optimisées pour les humains, privilégiant l’esthétique, l’ergonomie et l’attrait visuel (animations et mises en page colorées, par exemple). De ce fait, les agents conversationnels (AC) sont contraints d’imiter le comportement humain, ce qui accroît la complexité et l’efficacité. Grâce aux progrès réalisés dans les modèles de langages de programmation pour la génération automatique de sites web fonctionnels, le projet AUI soulève une question essentielle : les AC peuvent-ils jouer le rôle de « juges » pour aider les développeurs à concevoir automatiquement des interfaces graphiques ? Cette collaboration vise à créer des interfaces « natives pour les agents », en privilégiant l’efficacité des tâches à l’esthétique. Grâce aux retours des agents, le projet espère parvenir à une automatisation plus fiable et efficace des environnements numériques, en incitant les agents à passer d’une adaptation passive à une personnalisation active de leur environnement. Contributions principales 1. Plateforme de benchmark AUI-Gym : Ce benchmark est conçu spécifiquement pour le développement et les tests automatisés d’interfaces graphiques (GUI). Il couvre 52 applications réparties dans 6 domaines (applications, pages d’atterrissage, jeux, applications interactives, outils et utilitaires). Le projet utilise GPT-5 pour générer 1 560 tâches simulant des scénarios réels (30 par application) et garantit la qualité par une vérification humaine. Ces tâches mettent l’accent sur la fonctionnalité et l’interactivité, comme la création d’habitudes et la consultation de graphiques dans l’application « Micro Habit Tracker ». Chaque tâche est dotée d’un validateur basé sur des règles qui vérifie, via JavaScript, si elle est exécutable dans une interface donnée, permettant ainsi une évaluation fiable sans intervention humaine. Les indicateurs du benchmark incluent : • Complétude fonctionnelle (CF) : Évaluer si l'interface prend en charge la tâche (c'est-à-dire s'il existe un vérificateur de fonction), en tant que mesure d'utilisabilité de base. • Taux de réussite CUA (SR) : Évalue le taux d'achèvement moyen du CUA lors des tâches de navigation, reflétant l'efficacité d'exécution réelle. 2. Cadre de collaboration Coder-CUA : Ce cadre positionne le Coder (modèle de langage de programmation) comme le « concepteur », responsable de l’initialisation et de la révision itérative de l’interface graphique ; le CUA agit comme le « juge », fournissant des conseils par le biais de la résolution de tâches et de retours sur la navigation. Flux de travail spécifique : Coder génère un site web HTML initial à partir des requêtes des utilisateurs (notamment le nom, l'objectif, la fonction et le thème). • Site web de test CUA : tout d’abord, vérifiez la faisabilité de la tâche (collectez les tâches irréalisables comme retour d’information fonctionnel), puis effectuez la navigation (par le biais d’actions atomiques telles que des clics et des entrées). • Boucle de rétroaction : les tâches insolubles sont résumées dans un résumé linguistique destiné aux codeurs afin d’améliorer les fonctionnalités ; les trajectoires de navigation sont compressées en un retour visuel via le tableau de bord CUA pour aider les codeurs à optimiser la mise en page. 3. Tableau de bord CUA : Permet de condenser l’historique de navigation en plusieurs étapes de CUA (captures d’écran, actions et résultats inclus) en une seule image de 1920 × 1080 pixels. Grâce à un recadrage adaptatif des zones d’interaction clés, le nombre d’éléments visuels est réduit de 76,2 % en moyenne, tout en conservant les informations essentielles (objectifs, étapes et points d’erreur). Les retours sont ainsi plus interprétables, ce qui permet aux développeurs d’identifier les problèmes (faible contraste, mise en page complexe, etc.) et d’apporter des modifications ciblées : suppression de styles, augmentation du contraste, simplification de la structure, etc. Les résultats expérimentaux montrent que les programmeurs avancés (comme GPT-5) peuvent générer des interfaces graphiques attrayantes, mais que leur complétude fonctionnelle initiale est faible (de nombreuses tâches sont insolubles). Ce point faible peut être rapidement amélioré grâce au retour d'information sur les erreurs. La navigation CUA constitue le principal goulot d'étranglement ; même avec une fonctionnalité complète, le taux de réussite initial est faible. Cependant, grâce à l'itération collaborative (déstylisation, contraste élevé et simplification de la mise en page), le taux de réussite s'améliore significativement, démontrant ainsi que le retour d'information de l'agent renforce la robustesse et l'efficacité de l'interface graphique. Le projet souligne que les agents privilégient les interfaces simples et fonctionnelles à la complexité visuelle humaine. Adresse du projet de recherche

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.