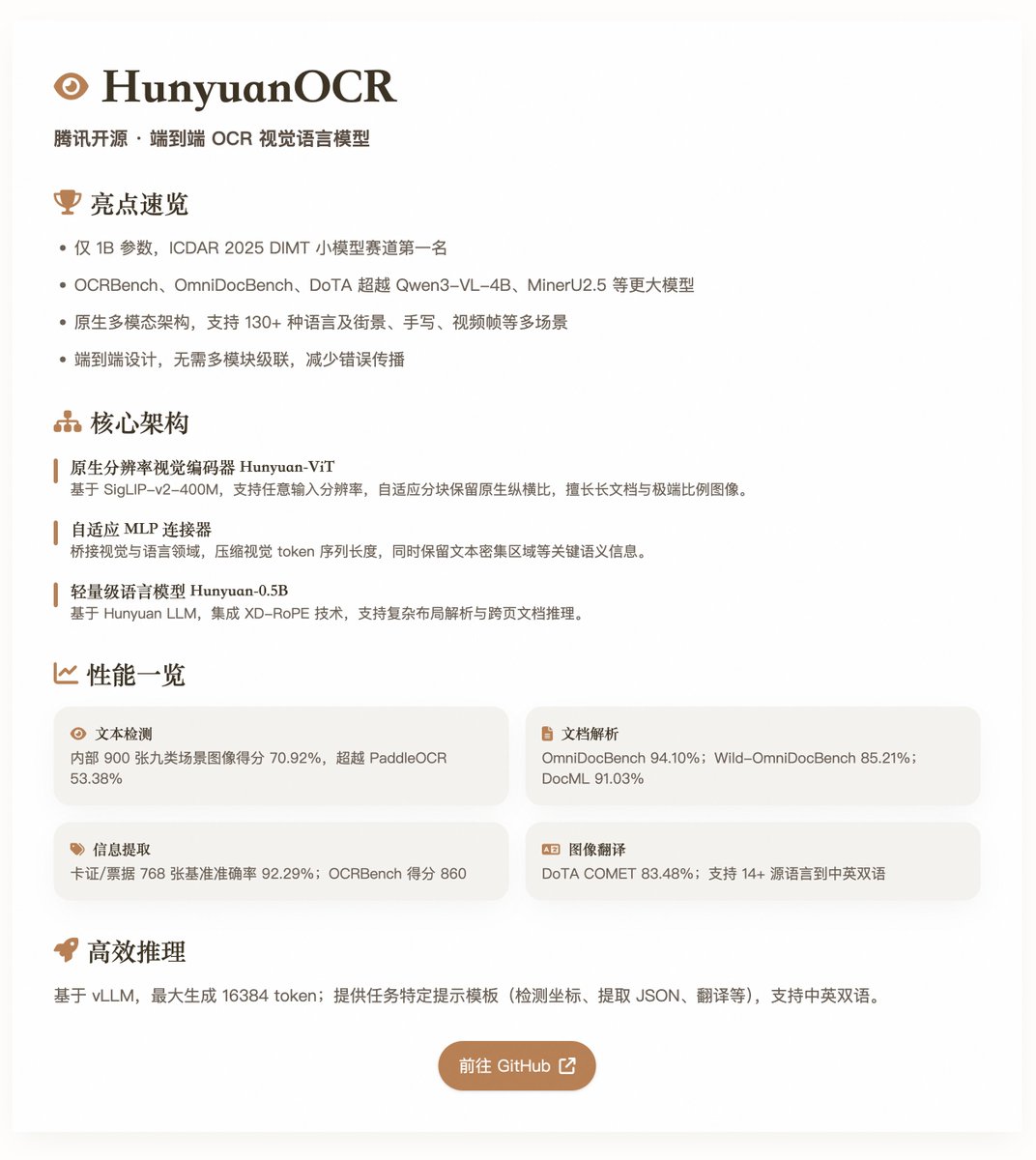

HunyuanOCR : le modèle de langage visuel OCR de bout en bout open source de Tencent HunyuanOCR, avec seulement 1 milliard de paramètres, a obtenu des performances exceptionnelles dans de nombreux tests de référence OCR. Basé sur une architecture multimodale native, il est optimisé pour les tâches d'OCR et convient à des scénarios tels que la détection de texte, l'analyse syntaxique de documents, l'extraction d'informations, la réponse visuelle aux questions et la traduction texte-image. Ce modèle a remporté la première place du défi DIMT ICDAR 2025 (catégorie « petits modèles ») et a surpassé de nombreux modèles plus complexes, tels que Qwen3-VL-4B et MinerU2.5, sur des plateformes de test comme OCRbench, OmniDocBench et DoTA. Caractéristiques principales et architecture HunyuanOCR utilise une conception de modèle de langage visuel de bout en bout, évitant ainsi la cascade multi-modules des systèmes OCR traditionnels et réduisant de ce fait la propagation des erreurs et les coûts de maintenance. Son architecture comprend trois composants principaux : • Encodeur visuel à résolution native (Hunyuan-ViT) : Basé sur le modèle pré-entraîné SigLIP-v2-400M comportant environ 400 millions de paramètres, il prend en charge des résolutions d’entrée arbitraires. Il préserve le rapport hauteur/largeur original des images grâce à un mécanisme de division adaptatif par blocs et excelle dans le traitement des documents longs, des images aux rapports hauteur/largeur extrêmes et des documents numérisés de faible qualité. • Connecteur MLP adaptatif : servant de pont entre les domaines de la vision et du langage, il effectue une compression du contenu spatial, réduit la longueur des séquences de jetons visuels et préserve les informations sémantiques clés, telles que les régions de texte denses. • Modèle de langage léger (Hunyuan-0.5B) : Basé sur Hunyuan LLM, avec environ 0,5 milliard de paramètres, il intègre la technologie XD-RoPE, décomposant RoPE en quatre sous-espaces : texte, hauteur, largeur et temps, prenant en charge l'analyse de mise en page complexe et le raisonnement sur les documents inter-pages. Ce modèle prend en charge la modélisation unifiée pour de multiples tâches, de la perception à la sémantique, grâce à des instructions en langage naturel (telles que « détecter et reconnaître du texte dans une image »), sans nécessiter de modules de prétraitement supplémentaires. Il couvre plus de 130 langues (y compris des langues à faibles ressources) et de nombreux scénarios (tels que les vues de rue, l'écriture manuscrite et les images vidéo), et privilégie l'utilisation de données de haute qualité adaptées à l'application ainsi que l'optimisation par apprentissage par renforcement (RL) lors de l'entraînement afin d'améliorer sa robustesse dans les scénarios complexes. Formation et construction des données (2 minutes) • Phase de pré-entraînement : Cette phase comprend quatre étapes, totalisant environ 454 milliards de jetons. Elle inclut l’alignement visuel-linguistique, le pré-entraînement multimodal, l’extension du contexte (jusqu’à 32 000 jetons) et l’ajustement supervisé orienté application. Les données combinent des jeux de données open source, des données synthétiques au niveau des éléments et des données d’application de bout en bout, pour un total d’environ 200 millions d’échantillons de haute qualité, couvrant neuf scénarios, dont la vue de rue, les documents et l’écriture manuscrite. • Phase post-entraînement : L’algorithme d’apprentissage par renforcement en ligne GRPO est utilisé, combiné à des mécanismes de récompense spécifiques à la tâche (tels que les systèmes basés sur des règles et le modèle linéaire logique comme juge). Ceci améliore considérablement la précision et la stabilité du modèle sur des tâches complexes comme l’analyse syntaxique et la traduction de documents. Le pipeline de données met l'accent sur la composition et l'amélioration : extension du framework SynthDog pour générer de longs documents multilingues, prenant en charge les mises en page RTL et les polices complexes ; introduction d'un pipeline de composition de distorsion pour simuler des défauts du monde réel (tels que le flou, la distorsion et les changements d'éclairage) ; et un pipeline de génération QA automatisé qui réutilise des échantillons inter-tâches pour garantir la diversité et la qualité. Évaluation des performances - Détection de texte (repérage) : Score de 70,92 % sur un benchmark interne de 900 images (neuf catégories de scènes), surpassant PaddleOCR (53,38 %) et Qwen3-VL-235B (53,62 %). • Analyse de documents : Score global de 94,10 % sur OmniDocBench, avec une distance d'édition de texte de 0,042 ; score Wild-OmniDocBench (capture de scène réaliste) de 85,21 % ; score DocML (multilingue) de 91,03 %. • Extraction d'informations et VQA : précision de 92,29 % sur un banc d'essai de 768 cartes/tickets ; extraction de légendes vidéo de 92,87 % ; score OCR Bench de 860. • Traduction de texte et d'images : Prend en charge plus de 14 langues sources vers le chinois/anglais, avec un score COMET de 83,48 % sur DoTA et de 73,38 % (autres vers l'anglais)/73,62 % (autres vers le chinois) sur DocML. Ces résultats mettent en évidence l’efficacité du modèle à un niveau léger, notamment dans des scénarios réels où il surpasse les VLM modulaires et les pipelines traditionnels. @vllm_project prend en charge l'inférence efficace, générant jusqu'à 16 384 jetons. Le rapport fournit des modèles d'indications spécifiques à la tâche, comme la détection de coordonnées, l'extraction JSON ou la traduction, et est disponible en chinois et en anglais. Modèle open source :

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.