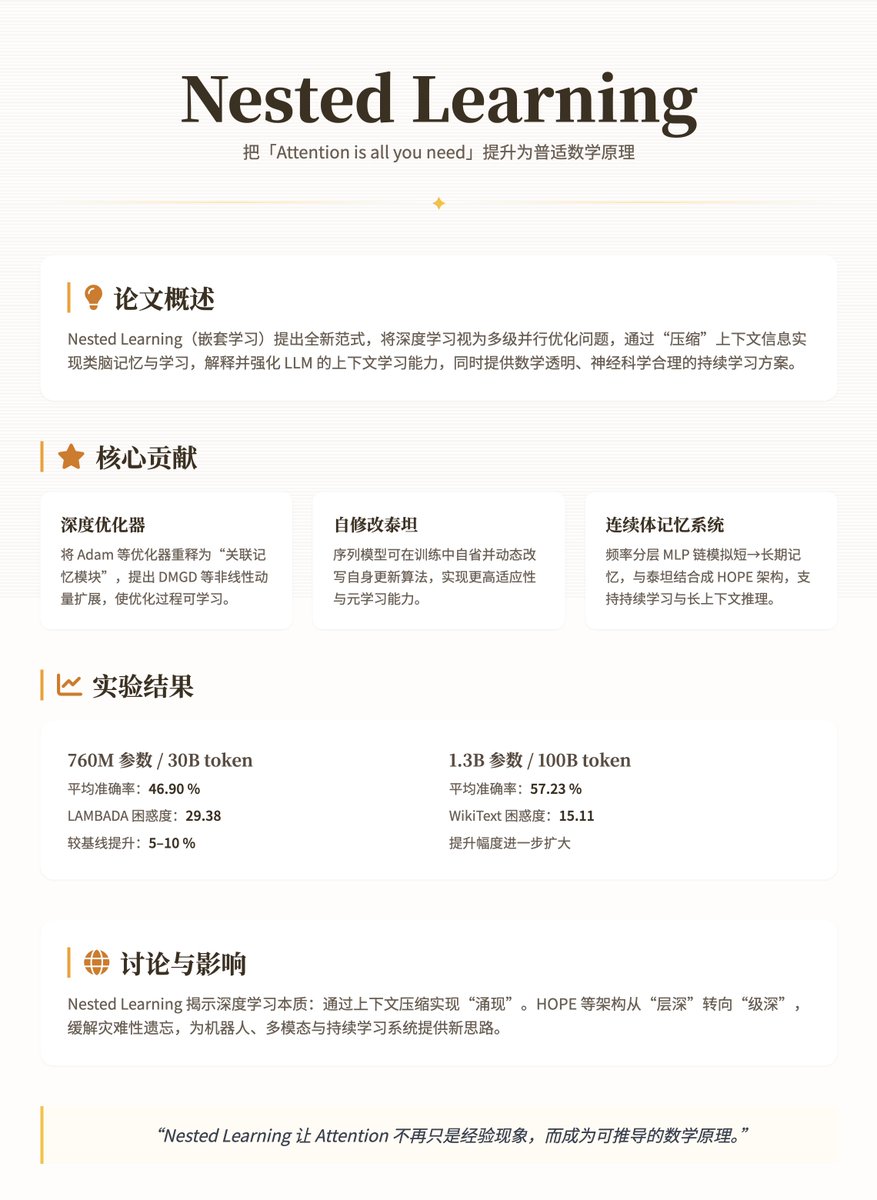

Le dernier article de Google Research, intitulé « Nested Learning », s'appuie sur le Transformer, élevant le slogan « L'attention est tout ce dont vous avez besoin » d'un phénomène empirique à un principe mathématique plus profond et universel. Cet article propose un nouveau paradigme d'apprentissage imbriqué pour réexaminer et améliorer les modèles d'apprentissage profond, notamment les modèles linéaires à plusieurs niveaux (LLM). L'argument principal est que l'apprentissage profond traditionnel ne se contente pas d'empiler des couches, mais « comprime » plutôt l'information contextuelle grâce à des problèmes d'optimisation imbriqués et multiniveaux, aboutissant ainsi à un mécanisme de mémoire et d'apprentissage similaire à celui du cerveau. Ceci explique non seulement les capacités d'« apprentissage contextuel » des LLM, mais fournit également une solution mathématiquement transparente et neuroscientifiquement rigoureuse pour surmonter leurs problèmes de statique et d'oubli. Les concepts et contributions fondamentaux de cet article modélisent les réseaux de neurones comme des problèmes d'optimisation parallèles imbriqués et multiniveaux, chaque niveau correspondant à un « flux de contexte » différent et à des fréquences de mise à jour décroissantes (par exemple, de la mémoire à court terme rapide à la consolidation à long terme lente). Cette approche s'inspire des processus de consolidation de la mémoire en neurophysiologie : le cerveau traite l'information par consolidation synaptique en ligne (ajustement en temps réel) et consolidation système hors ligne (stockage à long terme). L'apprentissage profond traditionnel est souvent considéré comme une « illusion » : il semble posséder une architecture profonde, mais repose en réalité sur des optimisations imbriquées implicites pour compresser les gradients ou les signaux d'attention. Les principales contributions de cet article portent sur trois aspects : 1. Optimiseurs profonds : Ces optimiseurs réinterprètent les optimiseurs (tels qu’Adam ou la descente de gradient stochastique à inertie) comme des « modules de mémoire associés » qui « mémorisent » l’historique en minimisant les pertes dues à la compression du gradient (comme la régression ℓ₂). Les auteurs étendent ces optimiseurs en introduisant, par exemple, la descente de gradient à inertie profonde (DMGD), en utilisant des réseaux multicouches pour gérer l’inertie non linéaire, ou en ajoutant des préconditionneurs pour améliorer l’expressivité. Le processus d’optimisation s’apparente ainsi davantage à un sous-module apprenable qu’à une règle fixe. 2. Titans auto-modificateurs : Modèle de séquence capable de modifier dynamiquement son propre algorithme de mise à jour (similaire au méta-apprentissage). Il permet à l’agent d’« analyser » et d’ajuster les mises à jour des paramètres pendant l’entraînement, ce qui lui confère une plus grande adaptabilité. 3. Système de mémoire continue (CMS) : une chaîne MLP à couches fréquentielles, chaque couche étant mise à jour à des cycles différents (par exemple, une fois toutes les C étapes), simulant le spectre continu de la mémoire à court terme à la mémoire à long terme. L’association du CMS avec le réseau Titan auto-modificateur forme l’architecture HOPE, un modèle de langage efficace qui prend en charge l’apprentissage continu et le raisonnement sur un contexte long. Ces contributions sont rigoureusement définies par des formules mathématiques (telles que l'objectif d'optimisation de la mémoire associative min_M ˜L(M(K); V), ou la mise à jour du momentum m_{t+1} = α m_t - η ∇L), garantissant transparence et évolutivité. Méthodes et détails techniques Le principe de la normalisation (NL) repose sur des mises à jour multi-échelles temporelles : le modèle est décomposé en couches linéaires ou mécanismes d’attention, chacun doté de son propre flux de gradient dédié. Par exemple : • L’entraînement MLP simple peut être considéré comme une optimisation en une seule étape, utilisant des signaux de surprise locaux (LSS, discordance entre la sortie et la cible) pour piloter la descente de gradient. Le mécanisme d'attention linéaire est en deux étapes : la couche interne met à jour la mémoire par similarité de produit scalaire, et la couche externe optimise la matrice de projection. • L'optimiseur, tel que l'inertie, est étendu à une mémoire clé-valeur : la clé est le gradient historique et la valeur est le préconditionneur P_i, permettant une compression plus robuste. L'architecture HOPE intègre un CMS (chaîne MLP multiniveau : y_t = MLP^{(f_k)}(...MLP^{(f_1)}(x_t)...)) et un mécanisme d'auto-modification, permettant le calcul parallèle et évitant la complexité quadratique du Transformer. Lors de l'entraînement, les couches internes sont mises à jour rapidement pour capturer les tendances immédiates, tandis que les couches externes intègrent progressivement les connaissances à long terme afin d'atténuer l'oubli catastrophique. Les auteurs ont testé des modèles comportant de 340 millions à 1,3 milliard de paramètres sur des tâches de modélisation du langage (WikiText, LAMBADA) et de raisonnement de sens commun (PIQA, HellaSwag, etc.), en utilisant des données pré-entraînées de 30 à 100 milliards de tokens. Les modèles de référence utilisés étaient Transformer++, RetNet, DeltaNet et Titans. Les résultats montrent que HOPE surpasse significativement HOPE en termes de perplexité et de précision. • Avec 760 millions de paramètres/30 milliards de paramètres de jetons, HOPE a atteint une précision moyenne de 46,90 % et une perplexité LAMBADA de 29,38, surpassant la référence d'environ 5 à 10 %. • Avec 1,3 milliard de paramètres/100 milliards de jetons, la précision moyenne est de 57,23 % et la perplexité WikiText est de 15,11, ce qui montre une amélioration plus significative. Discussion et impact Le paradigme NL révèle l'essence de l'apprentissage profond : l'obtention de capacités « émergentes » grâce à la compression du contexte, comme l'apprentissage avec peu d'exemples dans les modèles linéaires à niveaux (LLM). Cependant, il met également en évidence des limitations : les modèles sont sensibles aux variations de distribution après un déploiement statique. Des innovations telles que HOPE atténuent ce problème grâce à une imbrication multiniveau, incitant les architectures futures à passer d'une « profondeur de couche » à une « profondeur de niveau », avec des applications potentielles en robotique ou dans les systèmes multimodaux. Adresse du papier

Chargement du thread

Récupération des tweets originaux depuis X pour offrir une lecture épurée.

Cela ne prend généralement que quelques secondes.