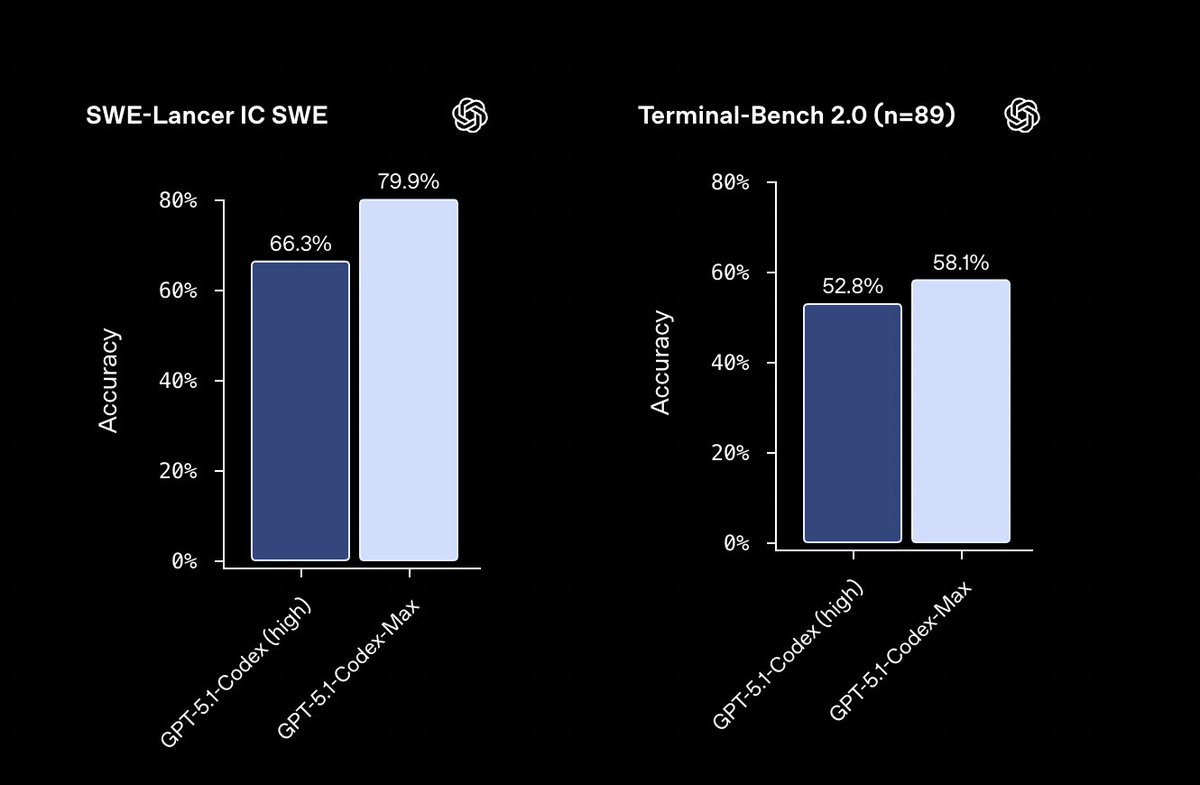

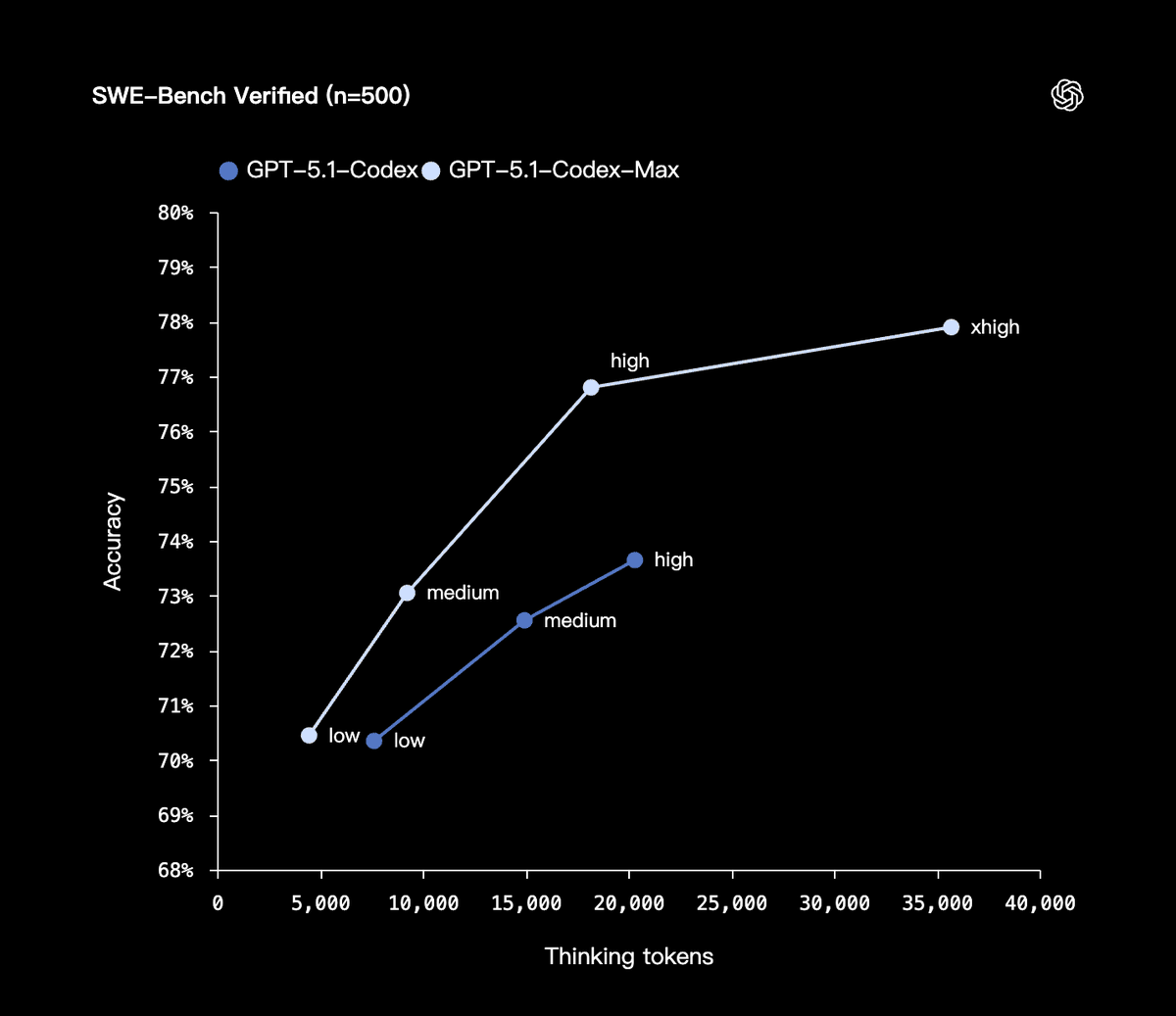

OpenAI a publié son nouveau modèle de code, GPT-5.1-Codex-Max, conçu pour traiter des bases de code extrêmement volumineuses et des cycles de développement longs, ce qui le rend plus rapide et plus économe en ressources, permettant d'effectuer des dizaines d'heures de travail en une seule fois. Le taux de vérification SWE-bench a atteint 77,9 %, soit 4 % de plus que la génération précédente ; Opter pour les tokens permet d'économiser 30 % par rapport à d'autres tokens de même qualité. Codex-Max peut comprendre des tâches complexes et les planifier, les exécuter et les réviser de manière itérative de façon autonome. Il utilise un nouveau mécanisme de compression capable de rationaliser le contexte de millions de jetons et de créer de l'espace pour des écritures ultérieures, garantissant une itération continue pendant 24 heures sans perte d'information. En interne, il a reconstruit indépendamment l'intégralité du dépôt Codex CLI, en boucle pendant 24 heures, en testant les échecs, en les corrigeant et en les réexécutant avant de finalement livrer. GPT-5.1-Codex-Max remplacera GPT-5.1-Codex et deviendra le modèle par défaut dans l'interface Codex. #openai #GPTCodexMax

Bloopenai.com/index/gpt-5-1-…fENH