Mes notes sur Gemini 3 # Version courte : Tout d'abord : vous avez tous vu les benchmarks, je pense donc que mon avis est superflu. Cependant, d'après mes tests, ce modèle est extrêmement performant et je tenais à vous en parler. Sur mes problèmes les plus complexes, il surpasse largement GPT-5 Pro, Gemini 2.5 Deep Think et tous les autres. Il s'agit du nouveau SOTA à : → Débogage de bogues complexes du compilateur → refactorisation de fichiers sans erreurs logiques → résoudre des problèmes difficiles de λ-calcul → Art ASCII (c'est presque correct maintenant !) → OU Gen 3 compétitif (je ne donnerai pas plus de détails 😭) Il s'agit néanmoins toujours d'un LLM. Il présente des modes de défaillance similaires et est même moins performant que Sonnet/GPT-5 dans certains cas. Il semble très mauvais en : → déduire l'intention → ne pas exagérer → codage d'ambiance à usage unique → écriture créative → questions de santé De plus, je soupçonne que ce point de contrôle n'est pas le meilleur dont dispose Google. Passons maintenant à une présentation complète et saisie manuellement de Gemini 3. --- # Version longue 1. Test d'ambiance : Programmation du λ-calcul J'aime ce test d'intuition car il est inviolable : dès qu'un modèle résout mon problème le plus difficile, j'en crée un plus difficile encore, en relevant légèrement le niveau requis. Antécédents actuels : → n-tuple-map : résolu par Grok 3 (février 2025) → n-tuple-fold : résolu par GPT-5 (août 2025) → n-tuple-rotl : résolu par Gemini 3 (aujourd’hui !) La mise en œuvre de rotl est impressionnante, car : → aucun autre modèle n'approche même de près la solution → La solution de Gemini est deux fois plus simple que la mienne. → Gemini 3 l'a résolu 5 fois plus vite que moi En fait, sa solution est si courte qu'elle tient sur une seule ligne : λn.λt.λk.(tλx.(nλg.λh.(h(gλq.λr.λs.(q(rs))))λu.λf.(fx)λu.uk)) Plutôt joli, non ? Cette minuscule fonction est un rotateur générique pour les tuples encodés en λ. À titre de comparaison, tous les autres modèles créent un terme cinq fois plus grand… qui ne fonctionne pas. Rien d’autre ne produit quoi que ce soit de semblable. Cette réponse m’a complètement sidéré. Je publierai un Gist contenant l'invite de commande et une solution exécutable. 2. Débogage en situation réelle Il y a quelques semaines, j'étais bloqué sur un bug coriace de HVM4. J'en ai parlé ici, déplorant qu'aucune IA ne puisse le résoudre. Eh bien, figurez-vous qu'une IA a réussi à le résoudre. Quelqu'un a exécuté ma commande sur un ancien point de contrôle via LMSys, et elle a trouvé la cause du problème : un dépassement de capacité négatif de la pile lors d'une optimisation spécifique. La solution était simple : remplacer `WNF_SPOS < 0` par `WNF_SPOS < spos`. C'était la première fois qu'une IA résolvait un vrai problème avant que je puisse le résoudre moi-même, ce qui m'a permis de passer à l'étape suivante et de réaliser de grands progrès. J'ai testé Gemini 3 sur de nombreux anciens messages de débogage, et il en a résolu la moitié. Des bugs qui me prenaient des heures sont maintenant corrigés par un ordinateur en une minute ! Malheureusement, j'ai signalé le problème de dépassement de capacité de la pile au modèle Gemini 3 lancé aujourd'hui, et il n'a pas réussi à identifier la cause. Donc, soit ce modèle n'est pas le plus performant de Google, soit j'ai eu beaucoup de chance ce jour-là. :( 3. Programmation/Refactorisation en situation réelle Ce modèle est excellent pour écrire des fichiers volumineux sans erreur. Par exemple, j'ai demandé à des IA de réécrire HVM4.hs en y apportant quelques modifications essentielles. J'ai ensuite examiné les fonctions les plus complexes. Comme prévu, tous les modèles ont échoué sur des points importants, ce qui a engendré des bogues graves – à l'exception de Gemini 3, qui a parfaitement réussi. C'est particulièrement encourageant pour moi, car les modèles se heurtaient à des limitations spécifiques comme la linéarité, les rendant inutilisables pour les fonctions HVM essentielles. Gemini 3 semble extrêmement performant dans ce domaine. (Code dans l'image ci-dessous.) 4. Problèmes et particularités J'ai demandé à Gemini 3 de générer une application web en une seule exécution, et le résultat était médiocre. GPT-5.1 (niveau élevé) m'a fourni un fichier complet, avec toutes les fonctionnalités demandées et sans aucun bug. Gemini 3 a généré un fichier trois fois plus petit, avec de nombreuses fonctionnalités manquantes et de nombreux bugs. Je n'ai pas réussi à obtenir avec Gemini 3 un résultat aussi bon qu'avec GPT-5.1. Je lui ai aussi envoyé mon questionnaire pré-méningite, et il a complètement écarté la méningite (💀). Je ne suis pas sûre de lui faire confiance pour les questions de santé. Je lui ai demandé d'écrire une histoire, et elle était mauvaise. Sans excuses. Il arrive souvent qu'il aille trop loin et écrive des fichiers complets au lieu de simplement colmater les brèches. Il semble plus lent que GPT-5 (niveau élevé) sur Gemini CLI, bien qu'il soit beaucoup plus rapide lorsqu'il est appelé directement ? Enfin, et c'est assez curieux, il a du mal à produire du code incorrect lorsque le contexte l'exige. Par exemple, si votre type possède une instance générique « Afficher » et que vous lui demandez d'en créer une personnalisée, il aura souvent des difficultés, car cela constituerait techniquement une erreur. Il ne comprend pas que vous supprimeriez simplement l'ancienne instance par la suite ! 5. Conclusion Assez tapé, au revoir

Le problème n-tuple-rotl : gist.github.com/VictorTaelin/1…Oy Le bug HVM4 d'il y a quelques semgist.github.com/VictorTaelin/a…TZwlZ264VI La bonne réponse est : - problème : `dépassement de capacité de la pile` - solution : `WNF_SPOS > spos` Le problème a été résolu par lithiumflow, mais pas par Gemini 3 :( Un modèle public peut-il résoudre ce problème ?

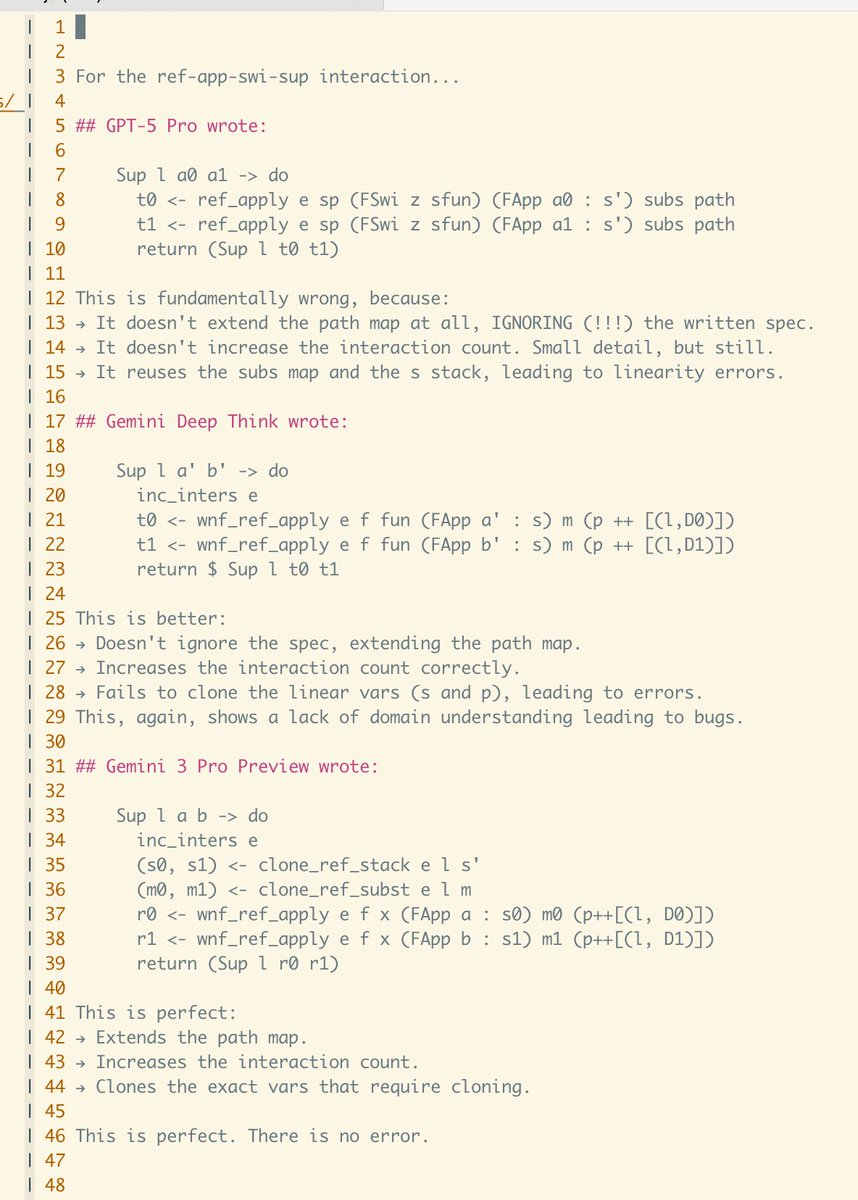

Évidemment, c'est le premier jour, alors prenez ça avec des pincettes, surtout pour les aspects que j'ai moins testés. On dit que c'est excellent pour l'écriture créative et la santé aussi. C'est possible ? Les problèmes d'interprétation des intentions sont bel et bien réels !