Un nouveau membre a été ajouté au modèle open source de grande envergure développé localement. Aujourd'hui même, Baidu a publié en open source un autre modèle de pensée multimodale : ERNIE-4.5-VL-28B-A3B-Thinking. Avec seulement 3 milliards de paramètres d'activation, ses capacités de compréhension et de raisonnement multimodaux se rapprochent de celles des modèles GPT-5-High et Gemini-2.5-Pro. Le principal atout cette fois-ci est sa capacité de « réflexion par l'image », qui permet aux utilisateurs de zoomer et dézoomer activement sur les images, d'observer attentivement les détails des images, puis de réfléchir et de répondre aux questions. Tout comme les gens, lorsqu'ils voient une image, ils la réfléchissent, la comprennent, puis expliquent à tout le monde ce qu'elle contient. Vous trouverez ci-dessous les cas de test officiels. Examinons-les :

Un mème classique illustrant la charge de travail réelle des travailleurs (Figure 1). Le modèle peut comprendre l'humour de l'image et explique en détail comment l'image touche avec précision les points sensibles des travailleurs modernes (Figure 2).

Photo d'un gâteau de lune périmé, la date de péremption de production étant floutée (Figure 1). Même si une personne zoome sur la photo à sa taille maximale, elle ne peut que difficilement le rendre clair, mais elle peut tout de même voir correctement que « le gâteau de lune est périmé » (Figure 2).

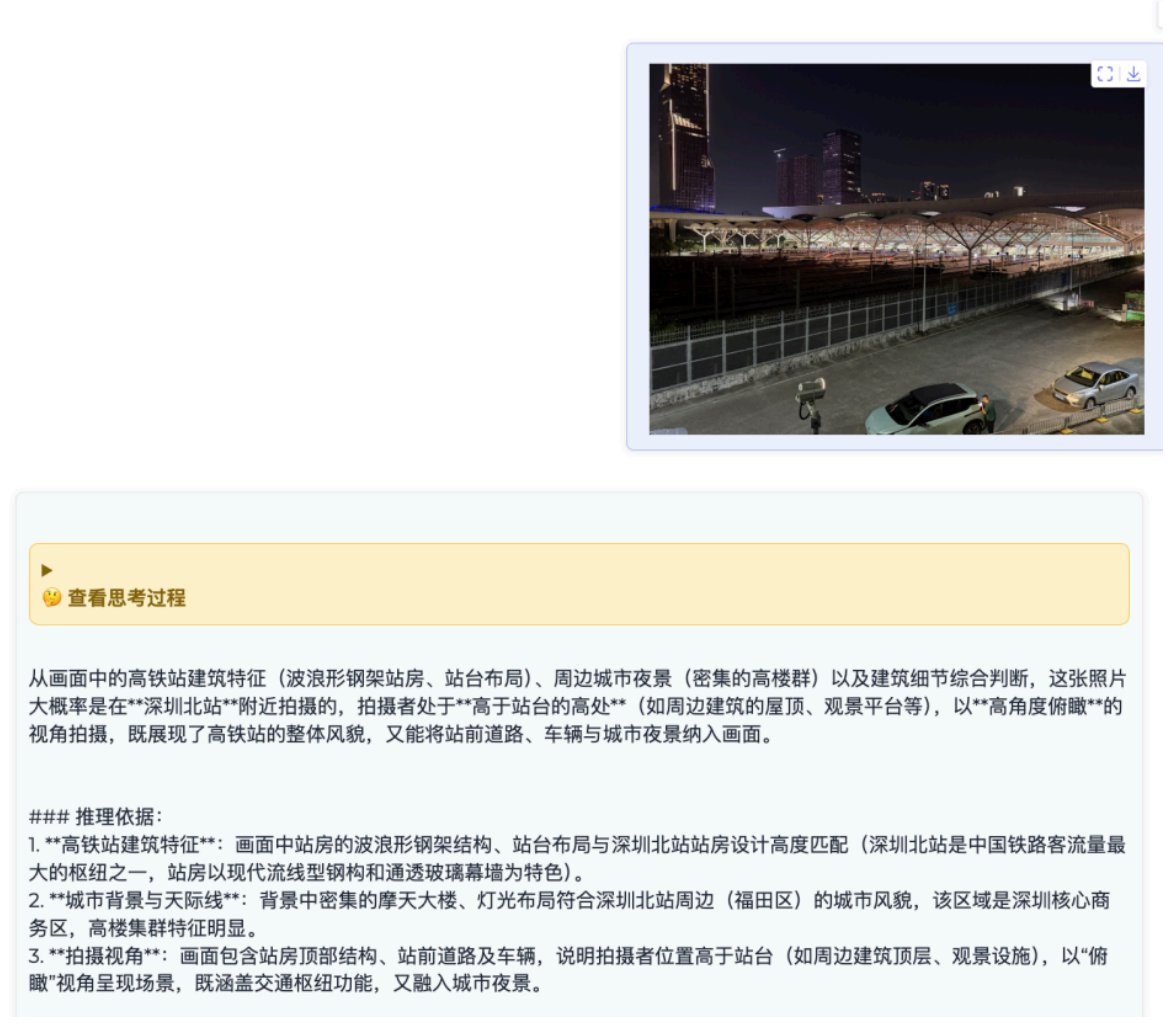

Également, une photo de nuit prise dans le nord de Shenzhen (Figure 1). Sans aucune indication, il peut déterminer le lieu précis de prise de vue en fonction des caractéristiques architecturales de l'image (Figure 2). Et cela repose sur un raisonnement et des preuves solides, ce qui est vraiment impressionnant.

Globalement, la capacité de « pensée par l'image » introduite par ce modèlhuggingface.co/baidu/ERNIE-4.…s performante ; elle semble capable de percevoir et de comprendre réellement les informations visuelles. Aucune démo en ligne n'est encore disponible, mais le modèle est open source. Téléchargement du modèle : https://t.co/WOYawrwuZL