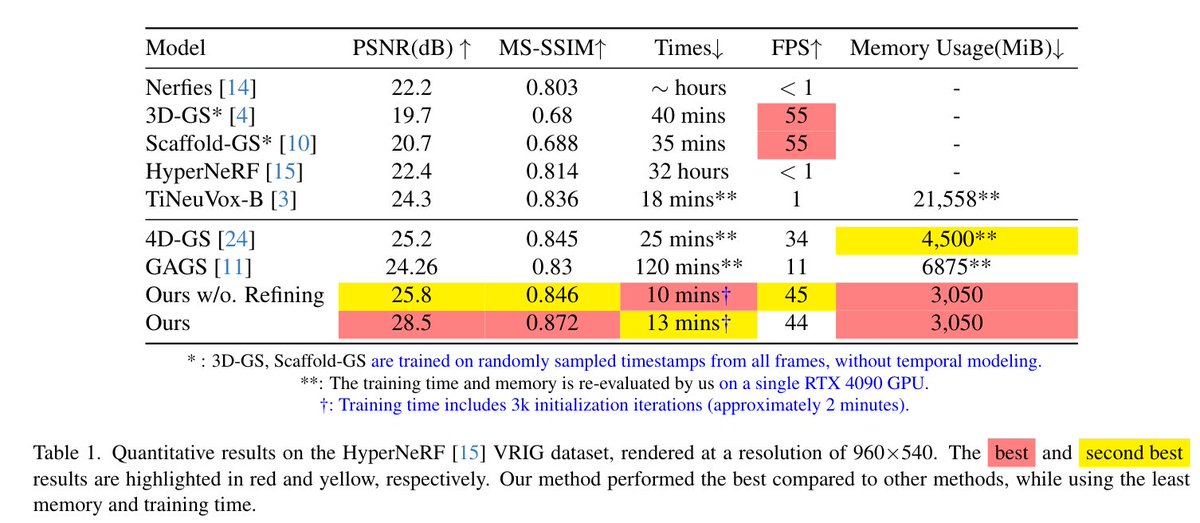

Projection de voxels neuronaux 4D : rendu de scènes dynamiques avec projection gaussienne voxelisée Contributions : • Architecture voxel 4D unifiée : Nous étendons les grilles voxel 3D à la 4D en considérant le temps comme une dimension supplémentaire dans l’espace des caractéristiques voxel. Ceci permet la génération de gaussiennes temporelles qui s’adaptent spatialement et temporellement. Contrairement à Scaffold-GS, qui génère des gaussiennes statiques, nos voxels produisent des gaussiennes variant dans le temps grâce à des caractéristiques temporelles apprises. • Stratégie de déformation sélective : Grâce à de nombreuses expérimentations, nous avons constaté que la déformation de toutes les propriétés gaussiennes entraîne une instabilité de l’apprentissage. Nous proposons une approche sélective qui ne déforme que les propriétés géométriques (position, échelle, rotation) tout en conservant les propriétés d’apparence (couleur, opacité) inchangées, ce qui améliore considérablement la convergence et la qualité. • Raffinement adaptatif au point de vue : Nous proposons un nouveau mécanisme de raffinement qui identifie et améliore sélectivement les points de vue sous-performants grâce à une densification adaptative, corrigeant les incohérences temporelles sans surcharge globale. • Conception efficace en termes de mémoire : Notre cadre atteint une complexité de mémoire O(fV + F) au lieu de O(N · T), rendant possible le rendu de scènes dynamiques sur les GPU grand public.

Articlearxiv.org/abs/2511.00560nwG