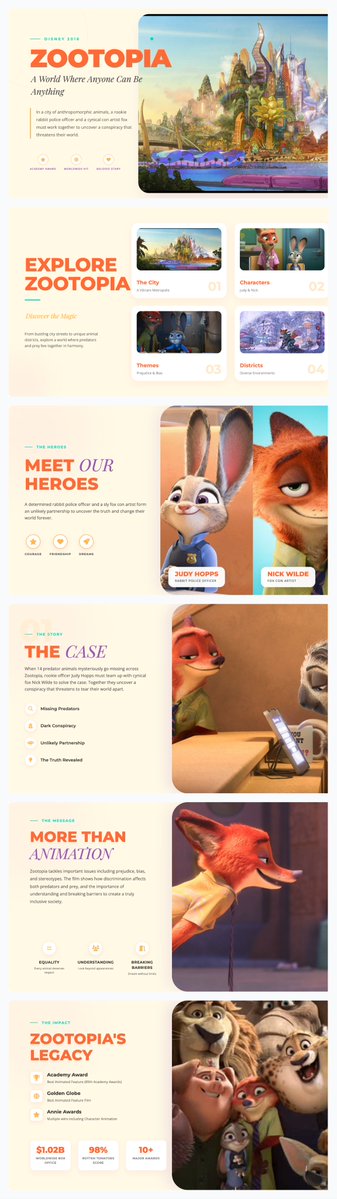

Zhipu AI lanza: GLM-4.7 presenta un modo de pensamiento de tres capas Antes de generar la respuesta, GLM-4.7 realiza automáticamente una inferencia interna: Analizar los objetivos de la tarea, formular rutas de razonamiento, predecir obstáculos potenciales y, finalmente, generar resultados visibles. También puede "recordar su proceso de pensamiento anterior" durante múltiples rondas de diálogo. Los usuarios también pueden "controlar la intensidad de su pensamiento". Al mismo tiempo, mejora significativamente la codificación y la estética del front-end, con un rendimiento que se acerca al de GPT-5 y Claude 4.5. Anteriormente, las páginas web generadas por GLM-4.7 se parecían al "trabajo de un desarrollador", pero ahora se parecen al "trabajo de un diseñador". Permite generar páginas web limpias y modernas, así como crear presentaciones y pósteres con un formato atractivo. Controla automáticamente el diseño, el color y las proporciones del texto para lograr una mayor consistencia visual. A continuación se muestra una presentación PPT generada por GLM-4.7.

GLM-4.7 ha realizado optimizaciones significativas en la **consistencia visual** del contenido generado: Genera automáticamente diapositivas de código HTML, CSS y JavaScript estructurados con diseño y proporciones mejorados, lo que da como resultado páginas web con un estilo moderno y usabilidad.

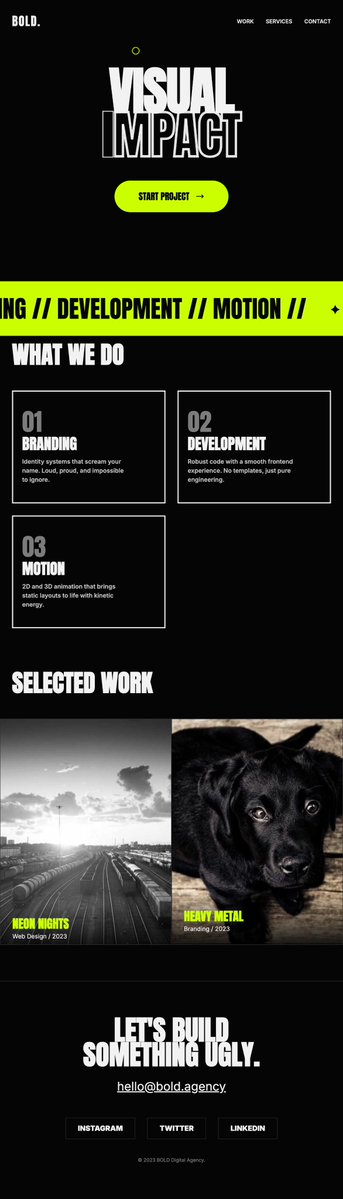

Sitio web diseñado con GLM-4.7 ↓

Gracias al modelo de razonamiento "pensar antes de actuar" GLM-4.7 ha mejorado significativamente las capacidades de codificación, con una tasa de finalización de tareas significativamente mejor que su predecesor (+10%~15%). El rendimiento de la tarea de programación alcanza el 90% del nivel Claude 4.5; Generación visual y de páginas web > Claude 4.5 Tiene ventajas en "generación de código + mecanismo de pensamiento + salida visual".

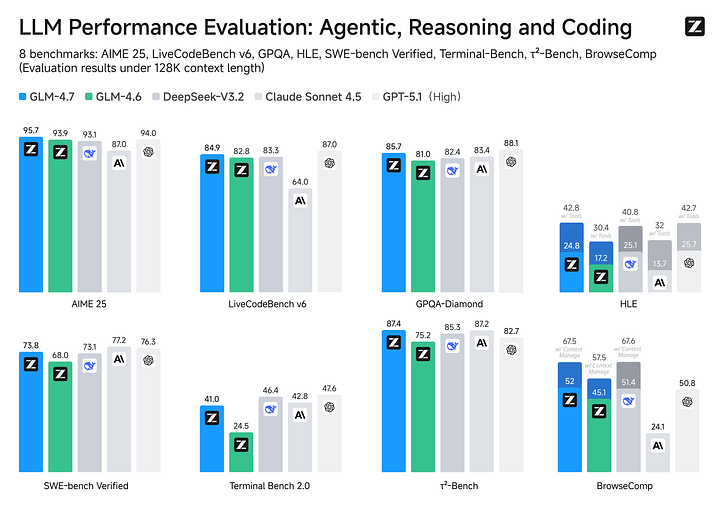

El rendimiento general de GLM-4.7 se sitúa entre GPT-5 y Claude 4.5. La lógica matemática está cerca de GPT-5 y es superior a Claude 4.5. En términos de capacidad de razonamiento, el GLM-4.7 tiene un rendimiento ligeramente peor en promedio que la serie GPT-5, pero supera al Claude Sonnet 4.5 y al Kimi K2. GLM-4.7 puede utilizar herramientas de forma activa, como buscar en línea o llamar a API externas. Consigue un 87,4% en τ²-Bench, superando a GPT-5 (82,7%).

Vívelz.aio/AfaqxyMkip Respecto al precio: Los usuarios del plan de codificación GLM se actualizarán automáticamente a GLM-4.7. Comparado con el modelo de Claude Code: El costo es 1/7 de su costo; Utilizando una cuota tres veces mayor que la de sus tareas de programación, el rendimiento alcanzó el 90% del nivel de Claude. Es una opción de gran valor.

Introxiaohu.ai/c/a066c4/ai-gl…s://t.co/Xp2huggingface.co/zai-org/GLM-4.7modelo: github.com/zai-org/GLM-4.5 GitHubdocs.bigmodel.cn/cn/guide/model…Yc Documentación de la API: https://t.co/Dn6U7WxNrW