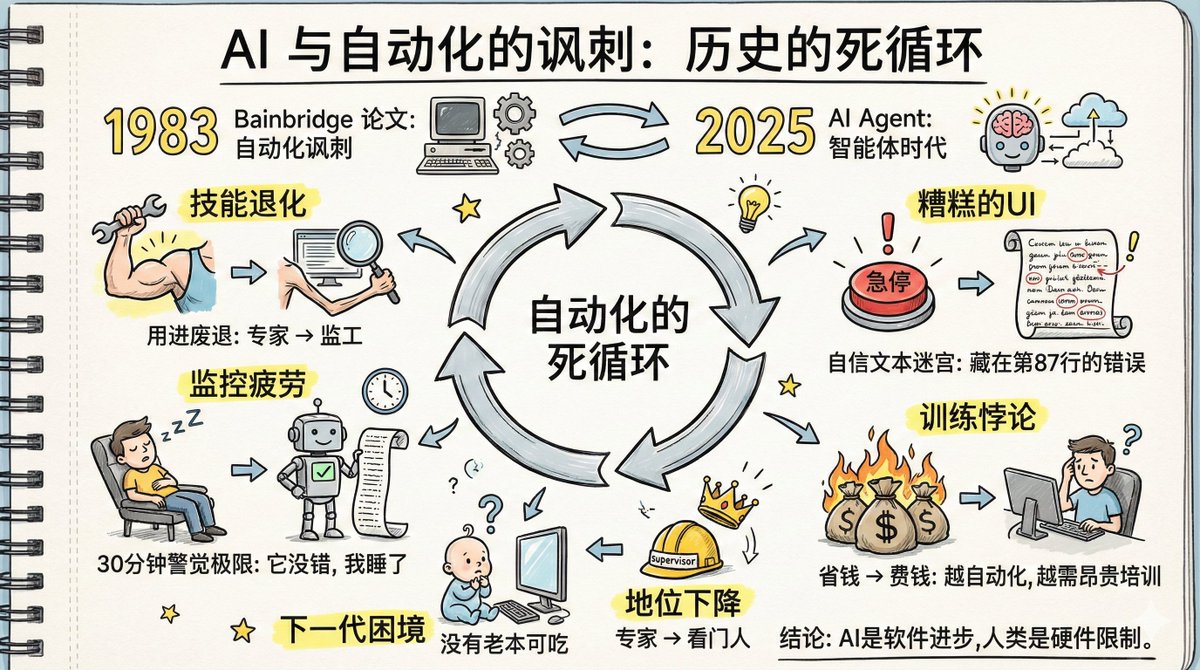

Hoy leí un artículo llamado "La ironía de la IA y la automatización", y su contenido es muy relevante para el desarrollo actual de la IA. En 1983, la psicóloga cognitiva Lisanne Bainbridge escribió un artículo titulado "La ironía de la automatización". Más de cuarenta años después, los problemas predichos en dicho artículo se están materializando, literalmente, en el caso de los agentes de IA. En aquel entonces, estaba investigando la automatización de fábricas: máquinas haciendo el trabajo y humanos supervisando. Hoy nos enfrentamos a la automatización de agentes de IA: la IA hace el trabajo, los humanos supervisan. El escenario ha cambiado, pero la lógica subyacente sigue siendo exactamente la misma. Y los problemas que señaló en su artículo están volviendo a ocurrir. ¿Qué temas se mencionaron en el documento? 1. El dilema de la degradación de las habilidades: las habilidades se atrofian cuando no se utilizan; las habilidades de los expertos se reducen cuando se convierten en supervisores. Todos entendemos el concepto de "úsalo o piérdelo". Pero en la era de la IA, tiene una versión más brutal. Antes, eras experto en un campo específico y lo hacías a diario con facilidad. Ahora, la empresa dice: «Deja que el agente de IA lo haga; tú eres responsable de supervisarlo e intervenir solo cuando surjan problemas». Suena genial, ¿verdad? Ascender de empleado a supervisor, ¿no sería más fácil? El problema es el siguiente: si dejas de hacerlo, tus habilidades no sólo no mejorarán, sino que incluso podrían deteriorarse. Como alguien que usa IA para escribir código a diario, siento que no he avanzado mucho en los últimos dos años y que me he vuelto dependiente de ella. Muchas líneas de código que antes podía escribir sin esfuerzo ahora son imposibles sin IA. En realidad es un caso de "úsalo o piérdelo". Tanto OpenAI como Anthropic promocionan la potencia de sus Agentes de Codificación, afirmando que sus empleados solo necesitan verificar el resultado de la IA. Sin embargo, omiten deliberadamente que estos individuos son expertos altamente cualificados y cuidadosamente seleccionados, con amplia experiencia para evaluar la precisión de la IA. Si, durante los próximos años, solo se centran en verificar el trabajo de la IA, sus habilidades se deteriorarán gradualmente. Nosotros, los programadores mayores, estamos bien, pero la próxima generación está en una situación aún peor. Los programadores veteranos de hoy al menos se formaron con la experiencia práctica. ¿Y qué hay de los programadores del mañana? Han estado observando la IA desde el principio, pero no han tenido mucho trabajo práctico. Carecen tanto de las habilidades como de la oportunidad de aprender. Entonces, ¿cómo juzgarán si la IA es correcta? Las palabras originales del artículo fueron: La generación actual de sistemas de automatización se basa en las habilidades de la generación anterior de operadores. Es poco probable que la próxima generación posea estas habilidades. Este problema quizá no sea evidente hoy, pero podría hacerse evidente dentro de tres a cinco años. 2. Dificultades de recuperación de la memoria: la recuperación de conocimientos poco utilizados es más lenta. Otro problema es que la memoria de habilidades relacionadas también puede deteriorarse. Recuerda esas fórmulas que nos sabíamos de memoria en el instituto; ¿cuántas podemos recordar todavía? En un escenario supervisado por IA, a medida que esta se vuelve más potente, suele ser correcta. Esto significa que, la mayoría de las veces, tus conocimientos no serán necesarios. A medida que tus conocimientos se usen cada vez menos, tus recuerdos relacionados se deteriorarán. 3. La paradoja de la práctica: La formación teórica es inútil; hay que aprender con la experiencia práctica. Sin embargo, la IA hace el trabajo, y los humanos no tienen la oportunidad de practicar. En este punto, usted podría estar pensando: ¿Es útil la formación? Sin embargo, el artículo "La ironía de la automatización" concluye que la formación no es muy útil. Las habilidades profesionales no se adquieren en clases magistrales, sino que se perfeccionan con la práctica real. Las teorías aprendidas en el aula suelen ser incomprensibles sin ejercicios prácticos, carentes de un marco experiencial correspondiente. Incluso si las entiendes al principio, las olvidarás rápidamente porque no existe una vía de recuperación de la memoria vinculada a las tareas del mundo real. Para mantener la capacidad de supervisar la IA, es necesario realizar el trabajo uno mismo con regularidad. Pero si el objetivo de la empresa es automatizar la IA para mejorar la eficiencia, las personas no tendrán muchas oportunidades de practicar. Este es un círculo vicioso. Como se afirma en el documento: Capacitamos a los operadores para que sigan instrucciones, luego las introducimos en el sistema y esperamos que proporcionen inteligencia. No se puede esperar que los humanos, que normalmente no necesitan pensar ni practicar, encuentren buenas soluciones en momentos críticos. 4. Monitorear la fatiga: los humanos no pueden mantener la vigilancia sobre sistemas que "raramente cometen errores" durante períodos prolongados. La investigación psicológica ha demostrado desde hace tiempo que los humanos no pueden mantener la alerta durante largos periodos con un objetivo que rara vez presenta problemas; media hora es el límite. Esto no es una cuestión de fuerza de voluntad, sino que está determinado por la estructura fisiológica. Desde una perspectiva evolutiva, esto representa una ventaja de supervivencia: si miras fijamente un punto y no ocurre nada, el cerebro reduce automáticamente su nivel de alerta, reservando sus recursos atencionales para afrontar amenazas reales. Pero en un escenario de vigilancia, esto se convierte en un problema. Los agentes de IA aciertan la mayor parte del tiempo, pero ocasionalmente cometen errores. Este es precisamente el patrón más difícil de monitorear. Si comete errores con frecuencia, se vuelve más vigilante. Si nunca comete errores, no es necesario monitorearlo. Pero la situación en la que rara vez comete errores cae en un punto ciego para la atención humana. Peor aún, los agentes de IA cometen errores de forma especialmente sutil. En lugar de decir "No estoy seguro", te explica su plan con un tono de total seguridad, extendiéndose a lo largo de decenas o incluso cientos de líneas. El error podría estar oculto en una premisa menor en la línea 87, como "Como 2 es mayor que 3, por lo tanto deberíamos...". Envuelto en tanto contenido aparentemente correcto, y aturdido por ese tono de seguridad, es difícil de detectar. ¿Qué tal añadir un sistema de alarma automático? El documento indica: ¿Quién supervisa el sistema de alarma? Si el sistema de alarma falla, el operador no lo notará, ya que ha estado funcionando normalmente durante mucho tiempo. ¿Qué pasa si alguien toma notas? El artículo afirma que las personas pueden copiar números mecánicamente sin prestar atención a lo que realmente son. Todos los intentos de combatir la fatiga de vigilancia se topan con el mismo obstáculo: la atención humana no puede centrarse en un objetivo que rara vez causa problemas durante un periodo prolongado. Se trata de una limitación de hardware, no de software. 5. Problema de estatus: La degradación de experto a supervisor resultó en un shock psicológico y una disminución del estatus social. Antes eras un experto; tus colegas acudían a ti con cualquier problema, eras respetado y tenías un fuerte sentido de identidad profesional. Ahora eres el guardián de la IA. La pérdida de habilidades es una cosa, pero el impacto psicológico es otra. Ser degradado de experto a supervisor, de creador a revisor, de ser necesario a ser suplente: este tipo de transformación es difícil de aceptar para muchos. El artículo afirma que las personas degradadas de esta manera exhiben diversos mecanismos complejos de afrontamiento, algunos de los cuales incluso parecen contradictorios. Esta parte es demasiado extensa para detallarla; quienes estén interesados pueden leer el artículo original. 6. Interfaz de usuario deficiente: la interfaz actual del Agente de IA representa el peor diseño de monitoreo. El campo de la automatización industrial ha dedicado décadas a optimizar el diseño de las salas de control: cómo organizar las pantallas para que los operadores detecten rápidamente anomalías, por qué el botón de parada de emergencia es rojo, por qué es tan grande y por qué está ubicado en ese lugar. Cada detalle es el resultado de las lecciones aprendidas de los accidentes. Ahora echemos un vistazo a la interfaz del Agente de IA. Un montón de textos largos y seguros, un plan de varios pasos tras otro, decenas o incluso cientos de líneas de explicaciones extensas. Tienes que encontrar el error oculto en todo ese texto. Esta es probablemente la peor interfaz de detección de anomalías jamás diseñada por la humanidad. 7. La paradoja del entrenamiento: cuanto más exitoso sea el sistema automatizado, más inversión se necesita para capacitar a los humanos. El artículo analiza los problemas de formación que plantea la automatización: Si los operadores no pueden asumir y realizar tareas personalmente periódicamente, es necesario el entrenamiento con simuladores. Sin embargo, los simuladores presentan un problema fundamental: solo permiten simular fallos previsibles. Los fallos desconocidos no se pueden simular, y los fallos conocidos pero no experimentados también son difíciles de simular con precisión. ¿Qué debemos hacer entonces? La capacitación solo puede cubrir estrategias generales, no métodos específicos de afrontamiento. Pero esto introduce un nuevo problema: no se puede esperar que los operadores gestionen las anomalías únicamente consultando el manual de operaciones, ya que este no puede abarcar todas las situaciones. Cuanto más exitoso sea un sistema automatizado, menos intervención humana requerirá, pero mayor será la inversión en capacitación del personal que necesitará. Porque cuanto menos intervención hay, más rápido se deterioran las habilidades de una persona, más débil se vuelve su capacidad para hacer frente a anomalías raras y mayor es el coste de cada sesión de entrenamiento. Los responsables de la toma de decisiones quieren ahorrar dinero con la IA, pero los costes de recursos humanos ahorrados pueden tener que duplicarse en costes de formación. 8. Dilema de liderazgo: supervisar la IA no se trata solo de observar pasivamente, sino de “liderarla” activamente. Supervisar a los agentes de IA no consiste solo en observar pasivamente, sino en dirigirlos activamente. Indicándoles qué hacer, qué no hacer, cuántos pasos dar y cómo ajustar su dirección. En realidad, ésta es una habilidad de liderazgo. ¿Por qué los gerentes suelen ser los que más elogian a los agentes de IA en LinkedIn? Porque están acostumbrados a trabajar indirectamente: estableciendo objetivos, asignando tareas, ofreciendo retroalimentación y ajustando la dirección, pero sin realizar el trabajo real. Para ellos, dirigir a un agente de IA no es diferente a dirigir a sus subordinados. Pero para quienes siempre han hecho el trabajo ellos mismos, esto supone un cambio radical de roles. Hay que pasar de ser alguien que hace cosas a alguien que deja que otros las hagan. Esto no se soluciona simplemente cambiando algunas indicaciones; es una reestructuración completa del conjunto de habilidades. La empresa ofrece formación en liderazgo a los gerentes recién ascendidos. Pero ¿alguien ha visto alguna vez que una empresa ofrezca formación en liderazgo a supervisores de IA? El artículo de hace cuarenta años terminaba así: Los humanos pueden ser excelentes solucionadores de problemas cuando no hay presión de tiempo. La dificultad radica en que la eficiencia disminuye drásticamente bajo presión de tiempo. Espero que este artículo aclare dos cosas: primero, la ironía es que la automatización no necesariamente elimina las dificultades; y segundo, la creatividad tecnológica necesaria para resolver estos problemas puede ser mayor que la propia automatización. Cuarenta años después, nos encontramos en un contexto diferente, pero enfrentamos el mismo conjunto de problemas. Los agentes de IA están mejorando, pero las estructuras cognitivas humanas permanecen inalteradas. La fatiga por monitorización aún dura solo media hora, la degradación de las habilidades sigue siendo una cuestión de uso y desuso, y persisten los puntos ciegos atencionales. Estas son limitaciones del hardware, no problemas que las actualizaciones de software puedan solucionar. Lectura recomendada: "Ironías de la automatización": https://t.co/5HWoelLIkR "IA y las ironías de la automatización - Parte 1" https://t.co/u27fpcCOWk "La IA y las ironías de la automatización - Parte 2"

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.