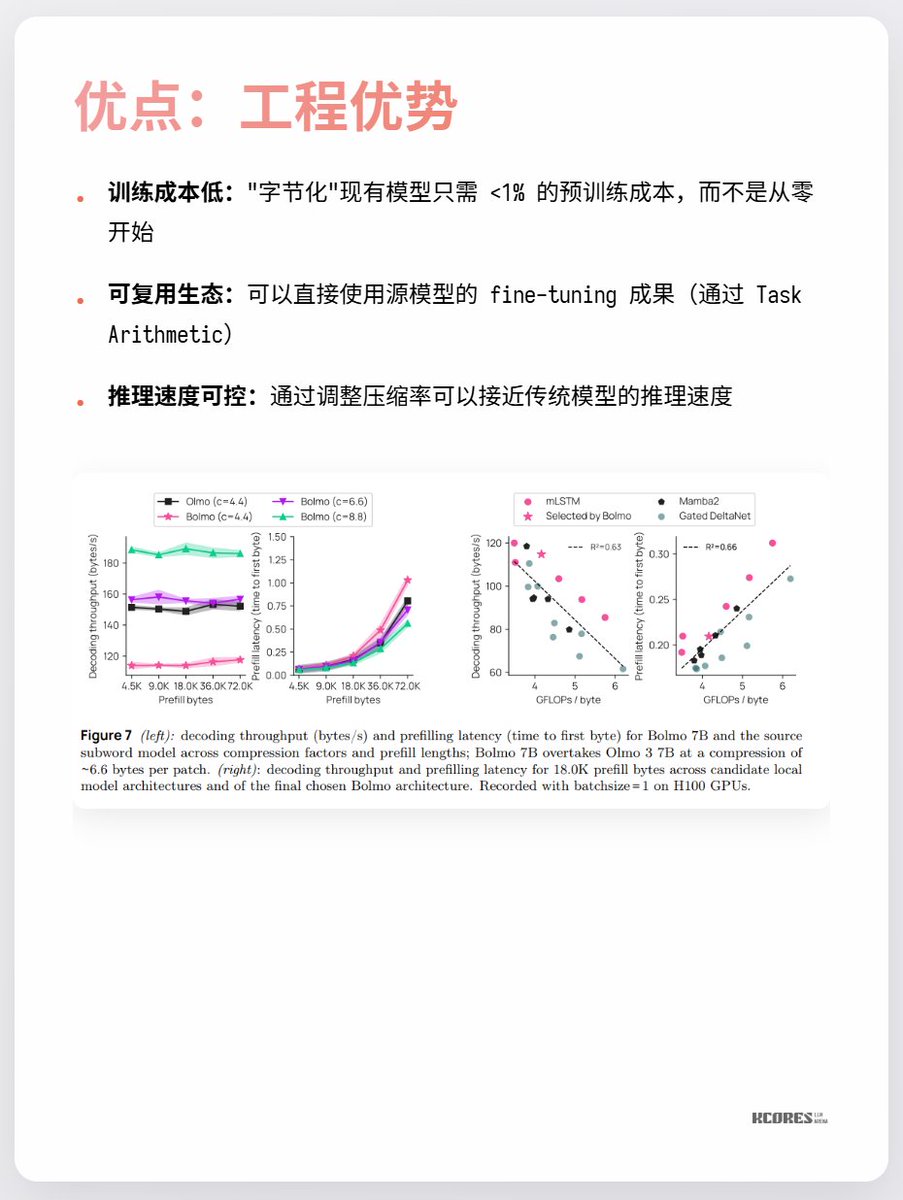

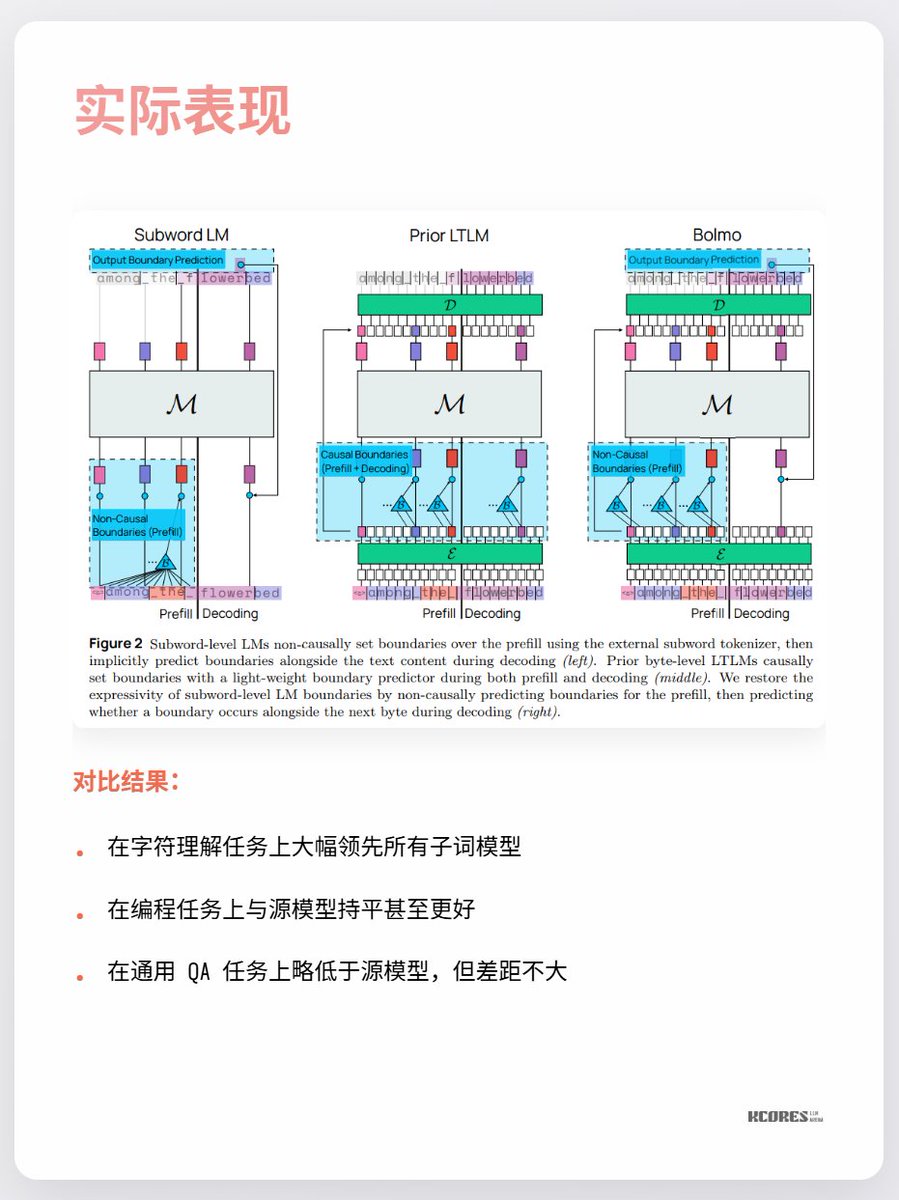

El modelo de Bolmo adopta un enfoque inteligente: en lugar de entrenar desde cero, codifica en bytes el modelo existente. Incorpora un codificador/decodificador local que comprime las secuencias de bytes en posibles tokens antes de introducirlos en un transformador tradicional para su procesamiento. Esto permite una conversión con una sobrecarga mínima.

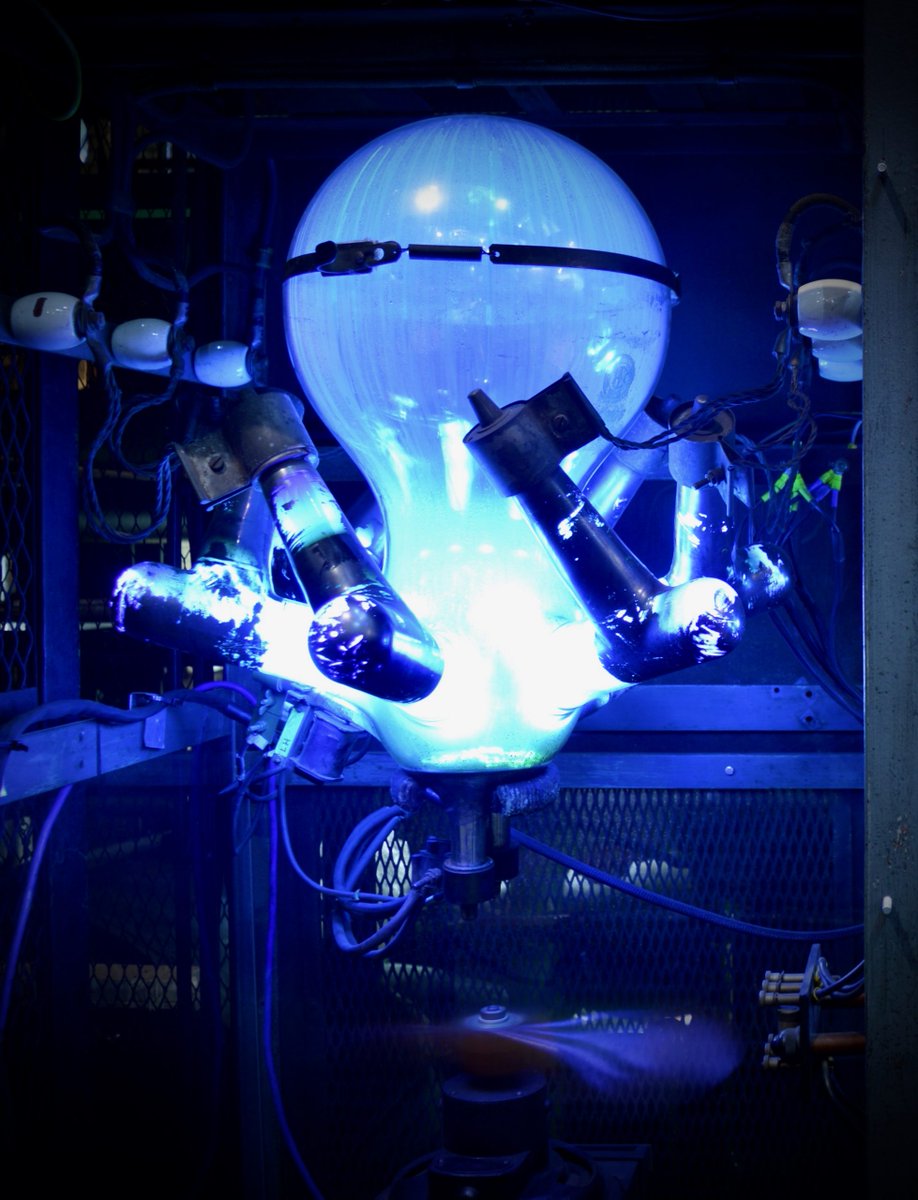

Los principales puntos de controversia actualmente son que no se observan grandes beneficios y que las secuencias más largas implican más caché clave-valor, lo que ejerce mayor presión sobre la memoria de la GPU. Además, la ventaja significativa solo se observa en la tarea de comprensión de caracteres, con escasas mejoras notables en otras tareas. En resumen, vale la pena seguirlo. La exploración de espirales durante periodos de avances tecnológicos siempre es muy interesante. Por ejemplo, a mí personalmente me gustaban los rectificadores de mercurio (última imagen), pero ahora han sido reemplazados por los IGBT.