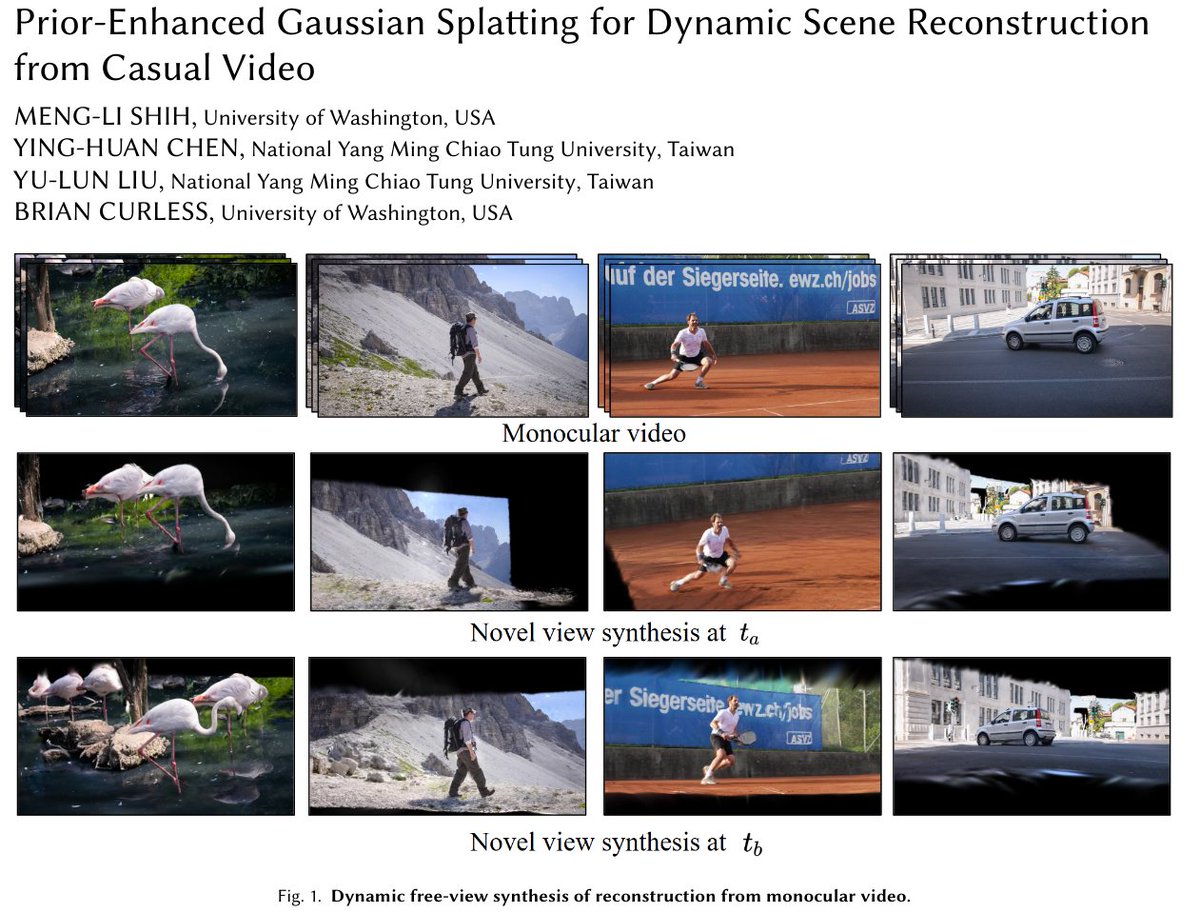

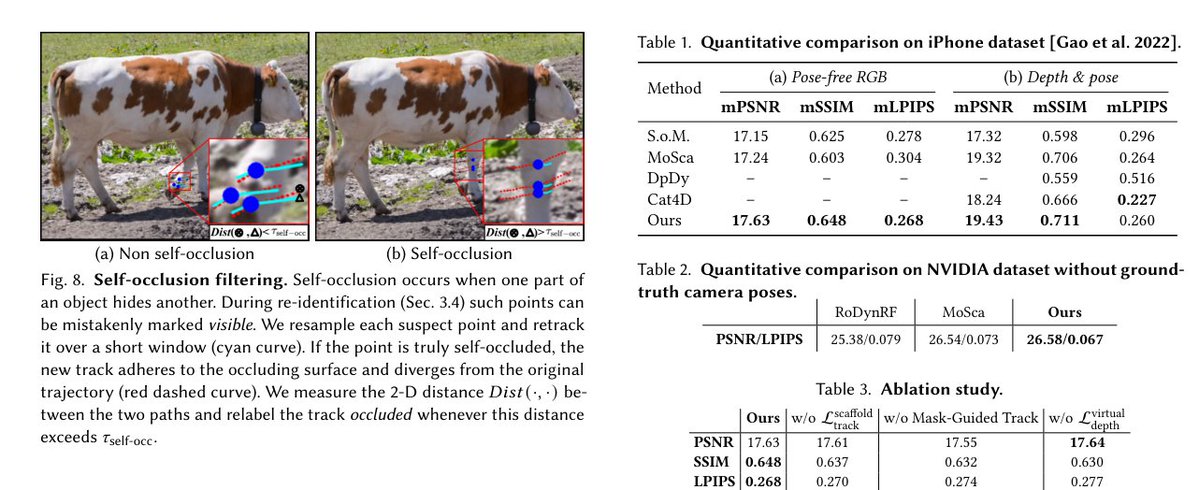

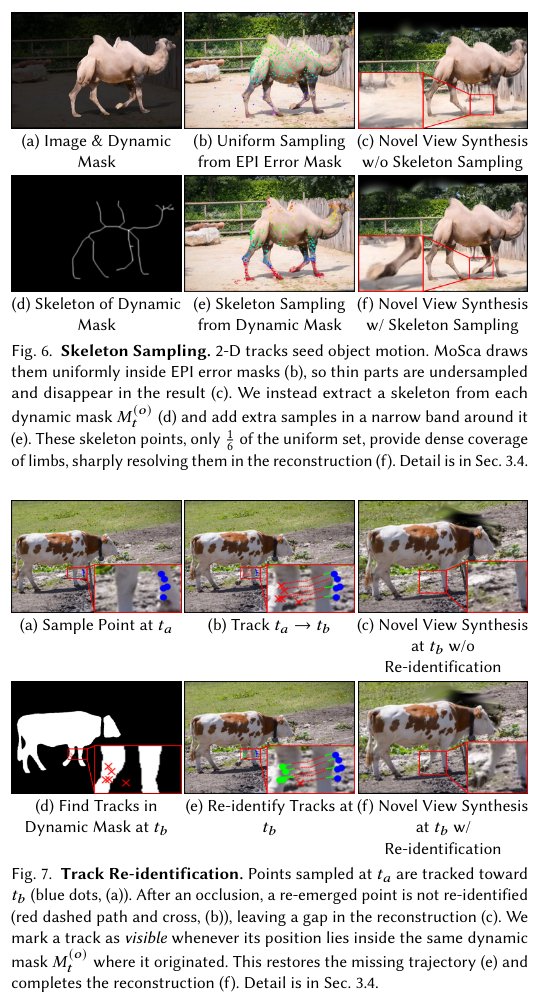

[SIGGRAPH Asia '25] Salpicadura gaussiana mejorada previamente para la reconstrucción dinámica de escenas a partir de videos casuales Abstracto: Presentamos un proceso totalmente automático para la reconstrucción dinámica de escenas a partir de vídeos RGB monoculares capturados casualmente. En lugar de diseñar una nueva representación de la escena, mejoramos los valores a priori que impulsan la dispersión gaussiana dinámica. La segmentación de video, combinada con mapas de error epipolar, genera máscaras a nivel de objeto que siguen de cerca las estructuras delgadas. Estas máscaras (i) guían una pérdida de profundidad del objeto que agudiza la profundidad constante del video, y (ii) facilitan el muestreo basado en el esqueleto y la reidentificación guiada por máscaras para generar pistas 2D fiables y completas. Dos objetivos adicionales integran los antecedentes refinados en la etapa de reconstrucción: - Una pérdida de profundidad de vista virtual elimina los flotadores. - Una pérdida de proyección de andamio vincula los nodos de movimiento a las pistas, preservando la geometría fina y el movimiento coherente. El sistema resultante supera los métodos anteriores de reconstrucción dinámica de escenas monoculares y ofrece representaciones visiblemente superiores.

Artículdl.acm.org/doi/10.1145/37…Fpj Proyepriorenhancedgaussian.github.io9UgOm