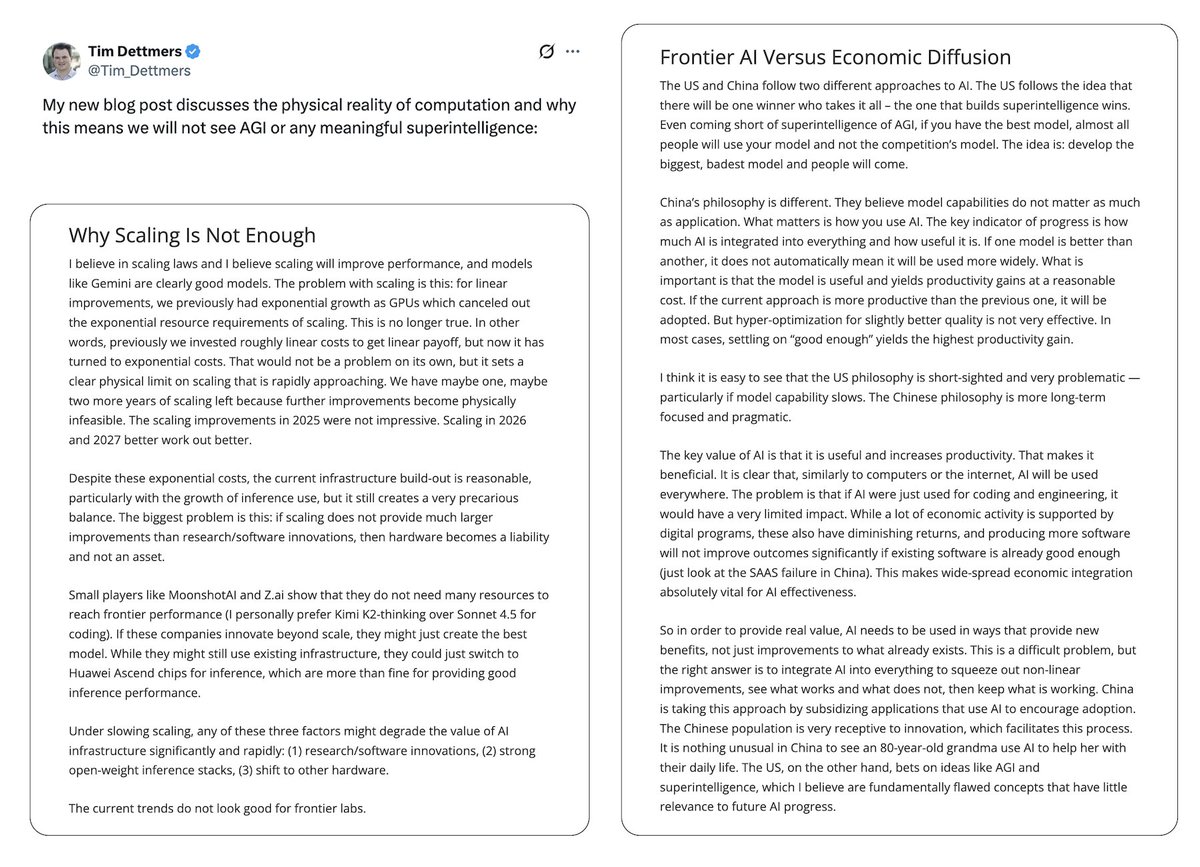

“¿Por qué la IAG no se implementará?” @Titimdettmers.com/2025/12/10/why…co/HBXAn0AJkp Vale la pena leer este ensayo. Analiza los rendimientos decrecientes (y los riesgos) del escalamiento. El contraste entre Occidente y Oriente: el enfoque de "el ganador se lo lleva todo" para construir lo más grande frente a un enfoque a largo plazo en la practicidad. El propósito de esta entrada de blog es abordar lo que considero un pensamiento muy descuidado, un pensamiento que se crea en una cámara de resonancia, especialmente en el Área de la Bahía, donde las mismas ideas se amplifican sin una conciencia crítica. Esta amplificación de malas ideas y pensamientos, emanada por los movimientos racionalistas y de la EA, es un gran problema para forjar un futuro beneficioso para todos. Un problema clave con las ideas, en particular las que provienen del Área de la Bahía, es que a menudo se limitan por completo al espacio conceptual. La mayoría de quienes piensan en IA general, superinteligencia, leyes de escalado y mejoras de hardware tratan estos conceptos como ideas abstractas que pueden discutirse como experimentos mentales filosóficos. De hecho, gran parte del pensamiento sobre la superinteligencia y la IA general proviene de la filosofía de Oxford. Oxford, cuna del altruismo eficaz, combinado con la cultura de la racionalidad del Área de la Bahía, dio lugar a una fuerte distorsión de cómo pensar con claridad sobre ciertas ideas.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.