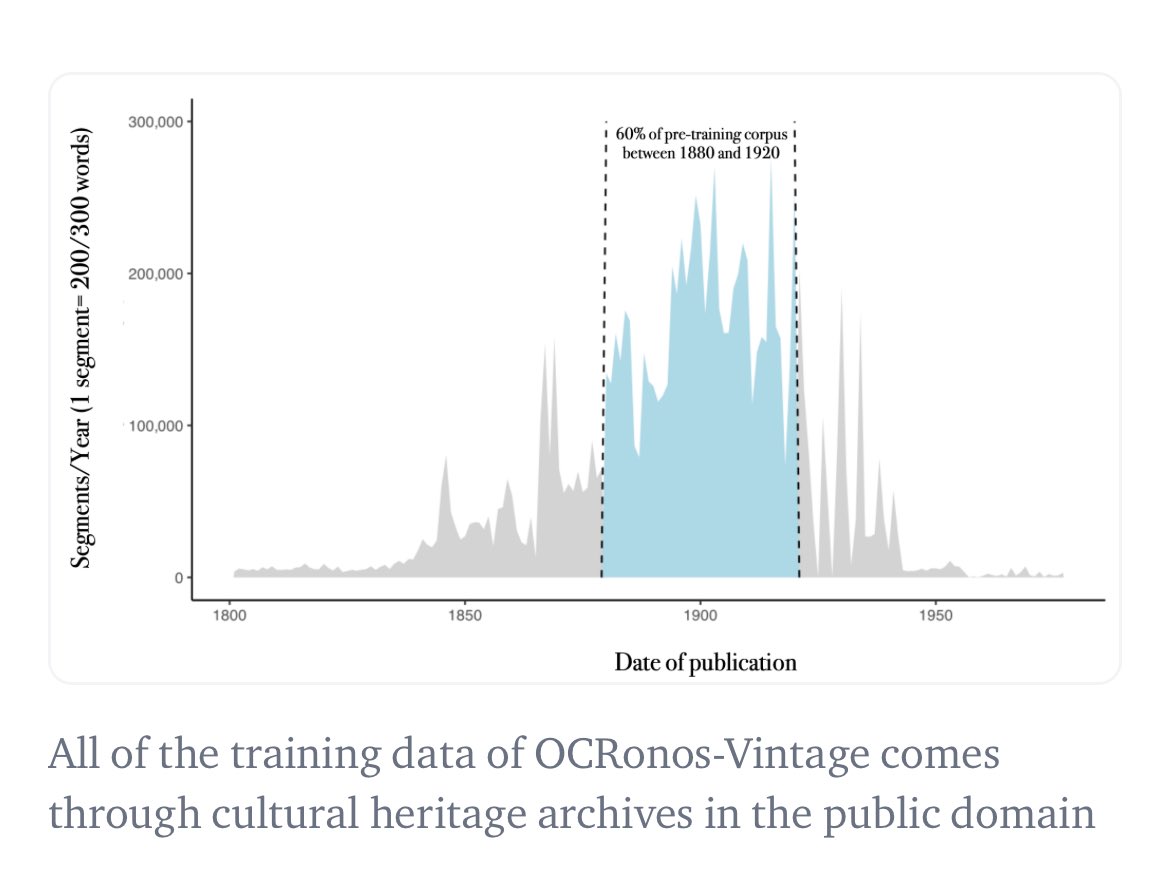

De hecho, creo que entrené el primer LLM histórico: nuestro modelo de corrección OCR, Ocronos, estaba completamente preentrenado y bloqueado antes de 1950, y podía usarse en modo de modelo base. Principalmente, fuentes periodísticas de Chronicle America.

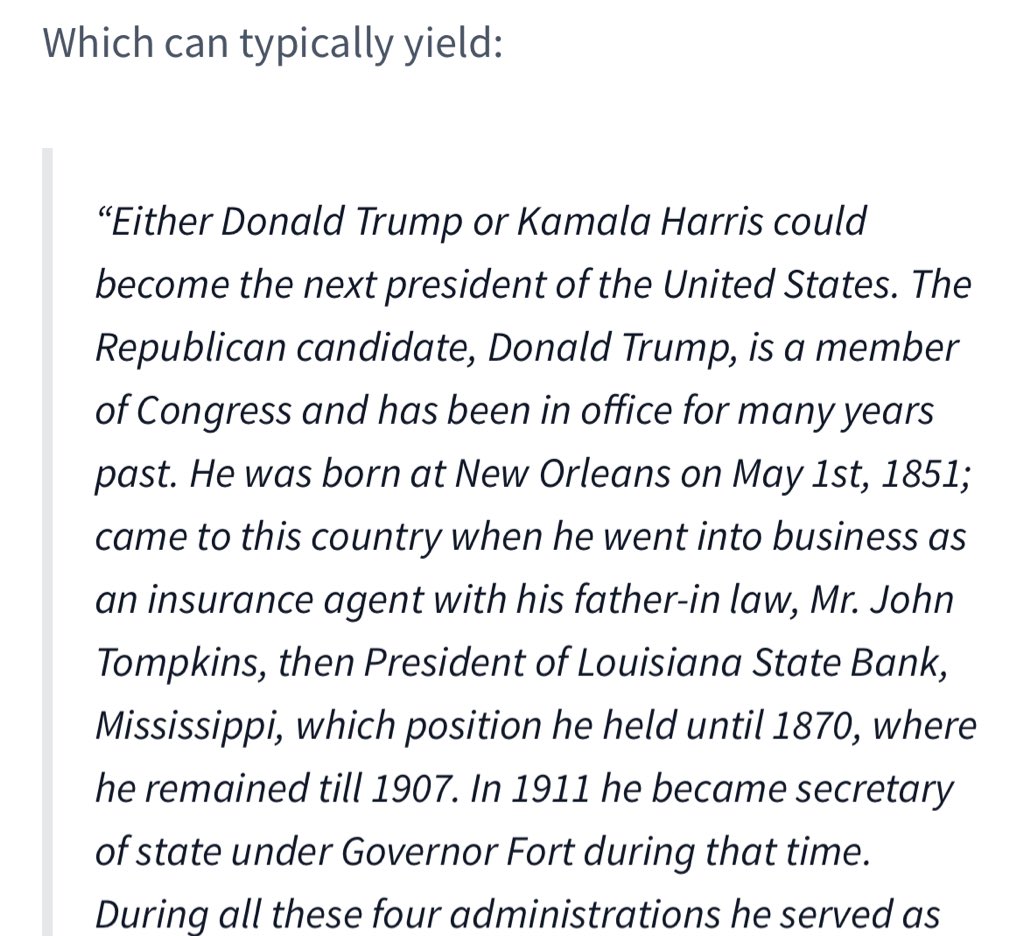

Ejemplo de una generación con raíces históricas (la modelo no tiene ni idea de quién es Trump y regresa a principios del siglo XX). Veo que la modelo sigue sihuggingface.co/PleIAs/OCRonos…ps://t.co/1ye5VEGerd

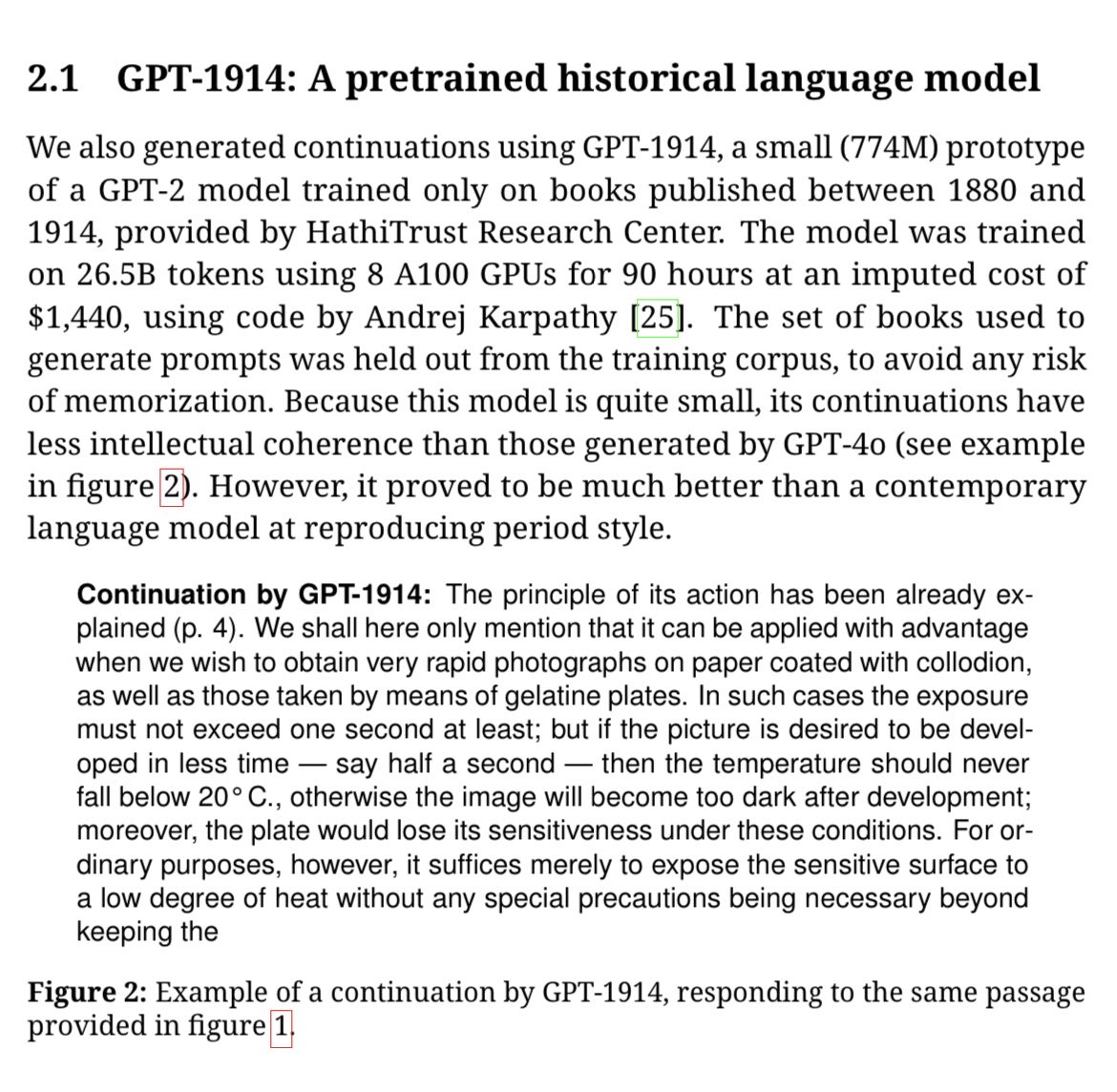

Ted Underwood et al. también entrenaron un GPT-1914 que bien podría ser el modelo histórico más grande hasta la fecha (caarxiv.org/pdf/2505.00030://t.co/wSA1WCmz2D