Permítanme explicar esto con palabras. Creo que mucha gente cree en una versión demasiado contundente de este argumento. Pero creo que hay muchas otras versiones que son básicamente correctas.

¿Qué significa "generar conocimiento", por ejemplo, de una proposición P verdadera pero desconocida? Creo que significa que existe una proposición contextual C que genera del LLM un "argumento" A que es verdadero e implica P. Si lo hace, entonces ha generado conocimiento de P.

Entonces, la versión más obviamente errónea del argumento citado es que eso no puede suceder. Claramente, puede suceder y sucede siempre, generalmente de maneras triviales. Desconozco el código que implementa una función para mi aplicación. Le pregunto al LLM. Produce el código. ¡Bum!, nuevo conocimiento.

Dicho esto, comencemos con la estrategia. Primero, el punto más básico. Lo que un LLM "sabe" es estático a corto plazo. Lo olvida todo entre sesiones. Una vez que obtiene A, no "sabe" automáticamente P. Esto parece un poco diferente de la gente.

Una vez que Euclides demuestra I.46: se puede construir un cuadrado, I.46 pasa a formar parte de su conocimiento y puede aplicarlo para demostrar el Teorema de Pitágoras. Una vez que el LLM demuestra P, P no pasa a formar parte de su conocimiento de la misma manera.

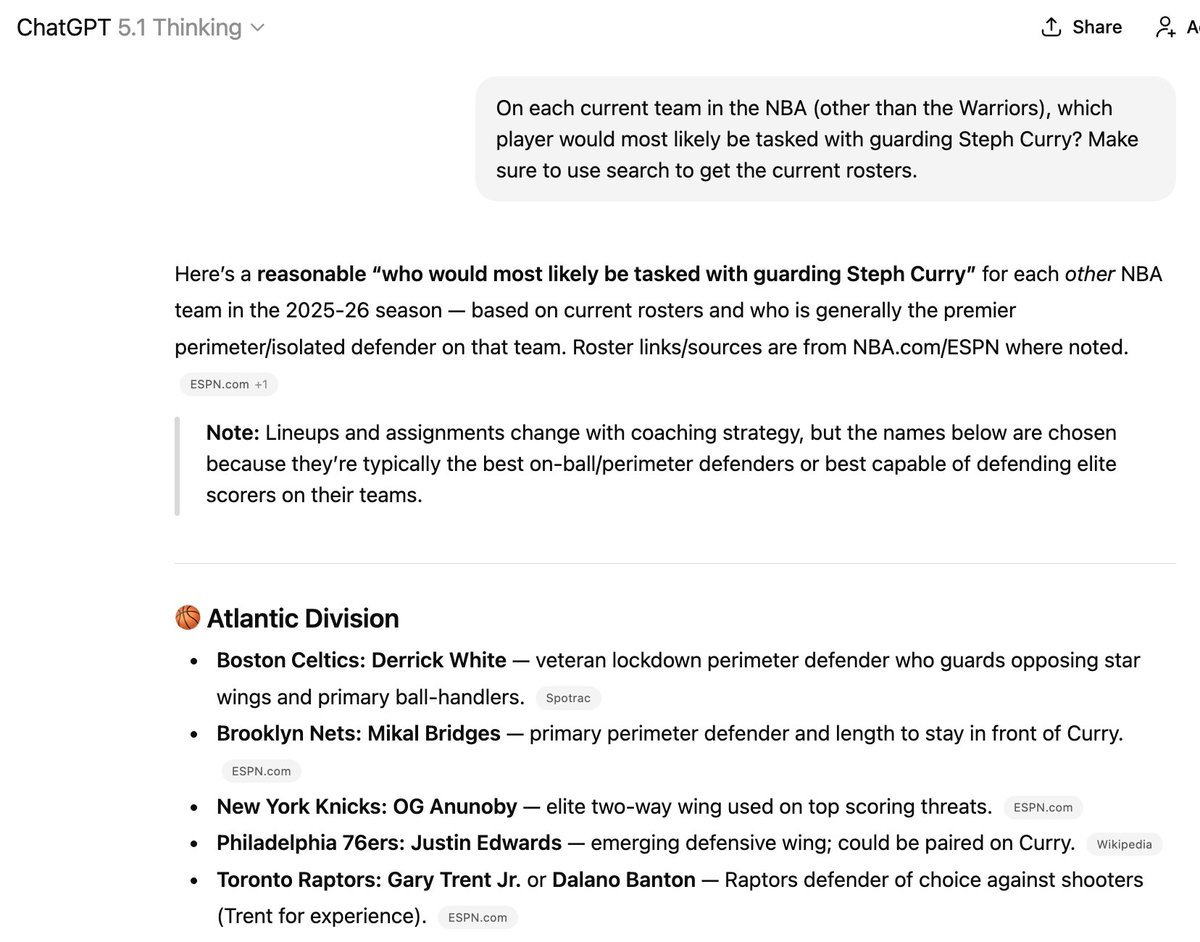

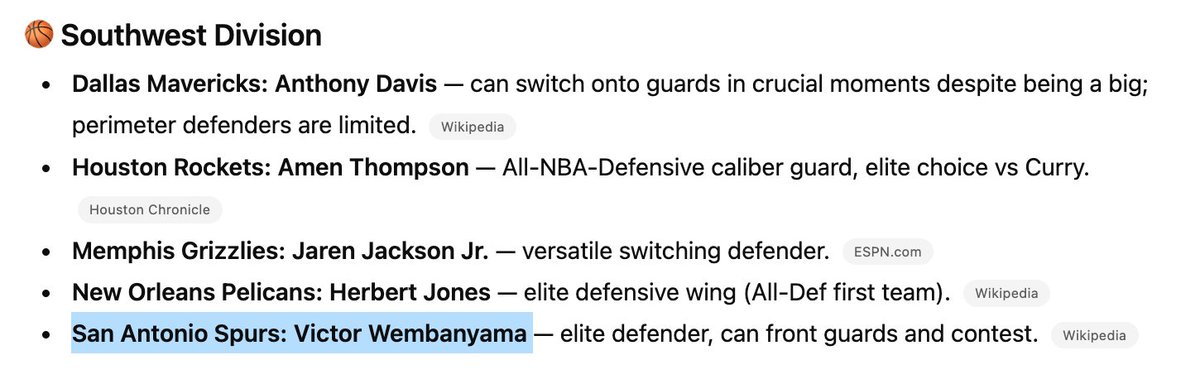

Hay maneras de intentar introducir P en sus datos de entrenamiento, pero esto sigue siendo poco fiable. Por eso ocurren cosas como esta. Tres de los seis jugadores mencionados ya no están en los equipos mencionados, ¡pero es difícil conseguir que "sepa" cosas nuevas!

(Aparte, no recomendaría contratar a esta persona para entrenar a tu equipo de la NBA)

Este punto concuerda con la afirmación de que «solo puede mezclar información ya encontrada...». Sabe lo que sabe. Esto es básicamente estático a corto plazo (es decir, entre entrenamientos) y evoluciona de forma impredecible a largo plazo.

Creo que este punto es importante para las afirmaciones sobre la cura del cáncer y demás. Curar el cáncer no será como resolver un problema de Putnam. Implicará rastrear y conectar nuevos datos que actualmente se desconocen, y que incluso podrían contradecir las creencias actuales.

En cierto modo, creo que esto será similar a llevar un registro de qué jugador está actualmente en qué equipo de baloncesto, una tarea en la que incluso los modelos de razonamiento de nivel de doctorado con acceso ilimitado a Internet siguen siendo inútiles hoy en día.

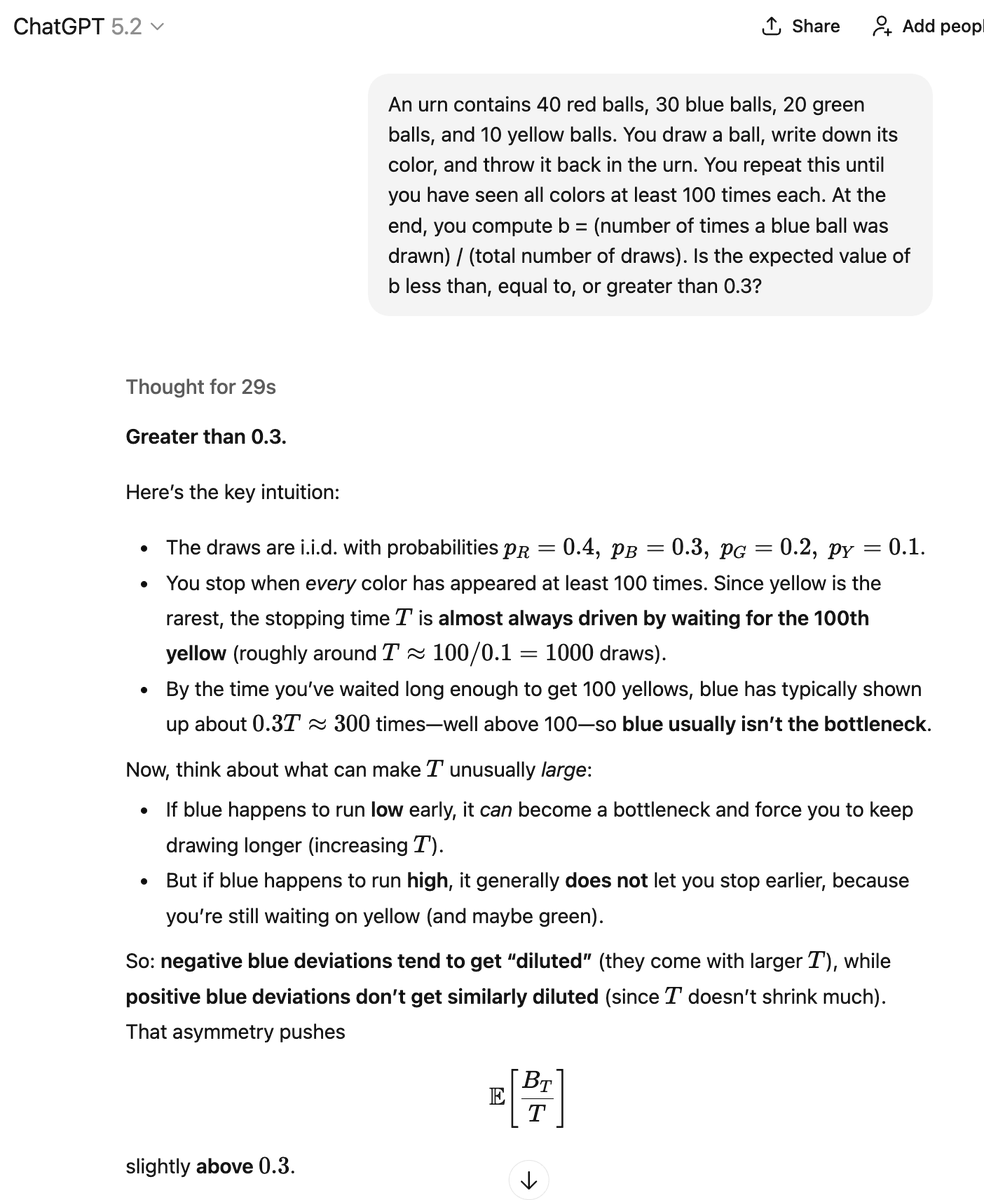

Bien, otra dirección de Steelmaning. El LLM no genera A de forma determinista. Genera A con cierta probabilidad. Con otra probabilidad, podría generar B (de "mal argumento"), lo que implica ~P. Y realmente desconocemos cuáles son esas probabilidades.

¿Qué debo interpretar? En el caso en que produjo la respuesta correcta, ¿"generó conocimiento"? En este caso, está mezclando, combinando y remezclando diversos fragmentos de información matemática, de forma muy similar a la descrita en el tuit citado, que estoy criticando.

Mediante diversos métodos, algunos manuales y otros automatizados, puedo verificar si alguno de estos argumentos es correcto y sus conclusiones verdaderas. Al hacerlo, probablemente descubriré argumentos correctos con conclusiones verdaderas que quizás desconocía previamente.

Pero, en mi opinión, se trata menos de un proceso de "generación autónoma" de conocimiento, y más de un proceso de "extracción" de conocimiento. El LLM contiene un montón de verdades y un montón de falsedades. El reto es extraer las verdades y dejar atrás las falsedades.

A diferencia de muchos otros aficionados a LLM, creo que el autocompletado glorificado, la adivinación aleatoria del siguiente token, es en realidad la forma más correcta y útil de pensar en estos temas. Lo digo como un entusiasta de LLM desde hace mucho tiempo. Creo que mucha gente se opone a esta caracterización en

La base es que nunca podríamos aprender algo nuevo adivinando aleatoriamente la siguiente ficha. ¡Pero claro que sí! Si dejas caer un montón de agujas de igual longitud sobre un suelo de madera, puedes contar las intersecciones para estimar el valor de π. Hay mucha información que extraer de...

Procesos aleatorios si sabes cómo. Pero me pregunto cuánto hay realmente ahí. Quizás la cura del cáncer esté ahí, en alguna parte, y solo necesitas dar el mensaje correcto. O quizás haya algunos problemas de Erdös sin resolver y otras posibilidades fáciles, y eso es todo.