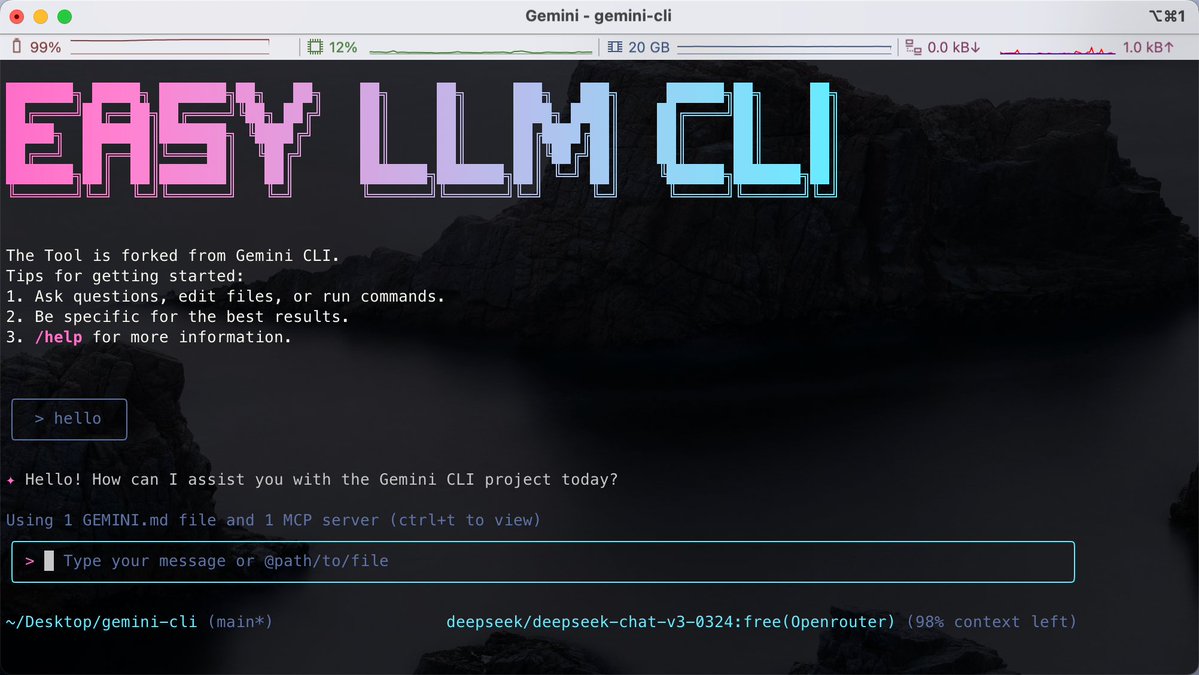

Para aquellos acostumbrados a escribir código en la terminal, el desafío a menudo radica en el hecho de que diferentes herramientas de IA están vinculadas a modelos específicos, lo que dificulta el cambio flexible entre varios modelos grandes dentro de la misma CLI. Descubrí el proyecto de código abierto Easy LLM CLI en GitHub. Es un desarrollo secundario basado en Google Gemini CLI, pero rompe las limitaciones de un modelo único. Es compatible con múltiples modelos como Gemini, OpenAI, Claude y DeepSeek, e incluso admite el acceso a modelos locales a través de Ollama. No solo admite MCP (Protocolo de contexto de modelo) para ampliar las capacidades de la herramienta, sino que también puede leer directamente el contexto del repositorio de código para ayudarnos a realizar automáticamente operaciones de Git, refactorizar código o generar aplicaciones. GitHub: https://t.co/MofOBwdQdw Requiere un entorno Node.js y se puede ejecutar directamente con npx sin necesidad de instalación. Puedes personalizar el backend del modelo que quieras usar mediante una sencilla configuración de variables de entorno. Esto es adecuado para desarrolladores que no quieren estar atados a un proveedor específico y prefieren manejar tareas de manera eficiente en la terminal.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.