¡El amor llega desde Francia, se lanza el modelo Mistral 3 Large! Sin embargo, ¿parece que llegó tarde? Esta vez, Mistral 3 Large finalmente se ha actualizado a la arquitectura MoE, con un total de 675 B de parámetros, 41 B de parámetros de activación y una longitud de contexto de 256 K. Lo probaron ellos mismos y descubrieron que el modelo base superó a DeepSeek-V3.1. Sin embargo, aún tengo dudas, ya que la serie Mistral no me causó una gran impresión en pruebas anteriores. Además, los Ministral 14B, 8B y 3B también se lanzaron al mismo tiempo. El equipo oficial los comparó directamente con modelos Qwen3 de parámetros similares. Si muchos estudiantes están interesados, consideraré darles a todos una prueba sencilla.

Parámetros del modelo / 1

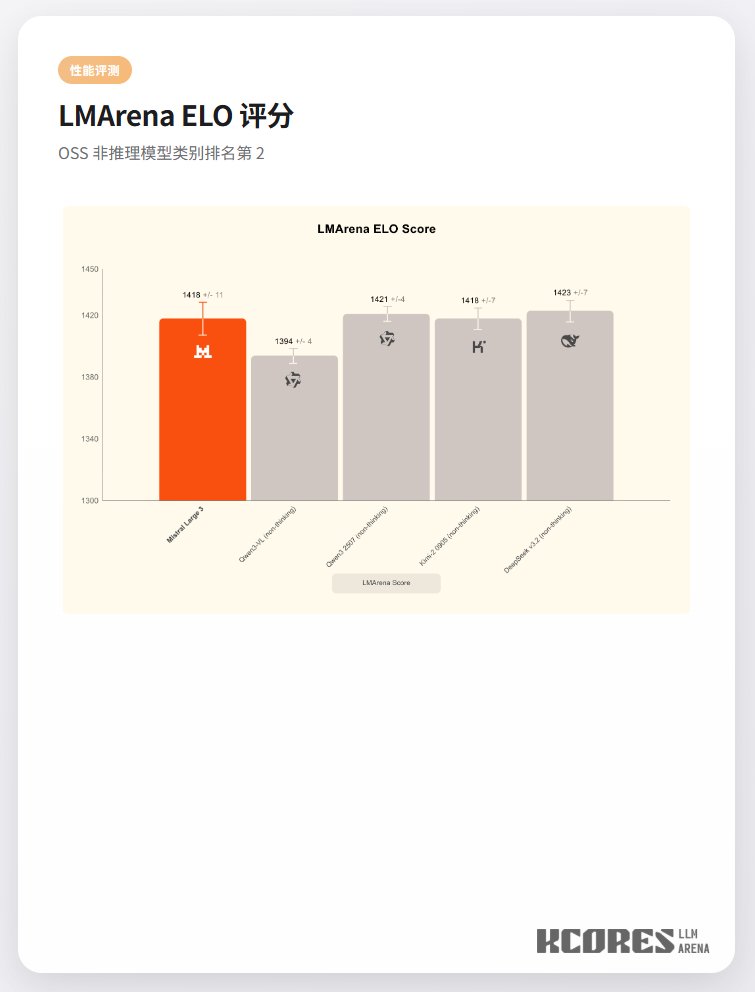

Rendimiento del modelo