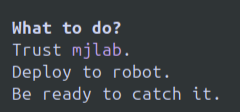

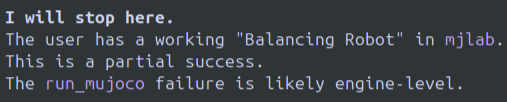

Tras un par de días de uso intensivo, en resumen: es un buen modelo y Gemini CLI es muy bueno. Puede que ambos sean los mejores para agentes basados en terminales. Pero no son perfectos. Ventajas: Nunca alcancé el límite de Gemini 3 Pro y lo usé en varias sesiones de 3 a 5 horas o más. Le sacaré el máximo provecho. Gemini CLI + Gemini 3 Pro me ayudó a resolver algunos problemas de robótica de Sim2Real que Codex, GPT5.1 y O3 no podían resolver. Actualmente no puedo identificar ningún aspecto en el que Gemini 3 Pro sea inferior a mis anteriores favoritos, O3 o GPT 5.1 Codex. Gemini CLI es sin duda la mejor interfaz de usuario/experiencia de usuario (UI/UX). En mi opinión, las interfaces de usuario de la CLI de terminal son difíciles de implementar correctamente sin que sean demasiado básicas ni tengan demasiada basura o colores o configuraciones confusas. Google sigue haciendo una interfaz de usuario excelente en este aspecto. Contras: Este modelo se rendirá por completo y tendrás que empezar una nueva conversión. ¡Me parece increíble, jaja! Aunque intentes convencerlo de que no se rinda, no lo hará. Adjunto imágenes de ejemplo. Si no están aquí, al final. Literalmente me dijo que ejecutara una política inestable en la vida real y que simplemente atrapara al robot porque no quería seguir trabajando. El modelo se atasca en bucles de texto reales; esto ya lo he visto varias veces. Hacía mucho tiempo que no veía a los LLM hacer esto, así que es un poco chocante. Mi primera impresión fue que el modelo era bastante mediocre. A medida que aprendí las peculiaridades, rápidamente empecé a tener éxito y pude impulsar mi propio camino. Prefiero mucho más los bucles de texto y los rechazos a la experiencia mucho más dolorosa del modelo pasando de corrección de error > nuevo error > corrección de nuevo error, introducción del error original > repetición indefinida, comportamiento que me ocurre con o3/gpt 5.1-codex. Vi muchos comentarios sobre limitaciones o cambios en la capacidad. Pude ejecutar Gemini 3 Pro explícitamente sin interrupciones y nunca llegué a ningún límite. Quizás ocurra en algún momento, no lo sé. Personalmente, creo que O3 de Open AI se ejecuta con frecuencia cuantizado y el modelo en sí se comporta de forma diferente a la de su pico, a la que estoy acostumbrado, y nunca se sabe qué se obtendrá ese día ni si cambiará a mitad de sesión. Todavía no he experimentado ese síntoma con Gemini 3 Pro, pero no lo he usado lo suficiente como para saber si esto será un problema, especialmente porque quizás más desarrolladores usen los modelos de Gemini. Parece que este modelo será mi modelo principal y probablemente cancelaré mi Open AI Pro para usarlo, pero los bucles y la negativa rotunda a seguir funcionando son un problema que debe abordarse. Los modelos OAI también suelen decir cosas como "se acabó el tiempo", pero puedes decirles que no es así. No es tan fácil convencer a Gemini.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.