2/n: momento "Soy tan tonto" (comparable al momento "ajá" de DeepSeek R1) El avance tecnológico más importante del artículo de DeepSeekMath-V2 no es el rendimiento de nivel Oro de la OMI. ¿Y qué es? Es la capacidad de otorgar a los modelos la capacidad de verificar de forma fiable su propia generación muestreada. Esto ha sido muy difícil para los LLM (incluso los de razonamiento). Cita: Cuando un generador de pruebas no logra producir una prueba completamente correcta de una sola vez (algo común en problemas complejos de competiciones como IMO y CMO), la verificación y el refinamiento iterativos pueden mejorar los resultados (hasta cierto punto). Esto implica analizar la prueba con un verificador externo y solicitar al generador que solucione los problemas identificados. Sin embargo, observamos una limitación crítica: cuando se le pide que genere y analice su propia prueba de una sola vez, el generador tiende a afirmar que es correcto incluso cuando el verificador externo identifica fácilmente los fallos. En otras palabras, si bien el generador puede refinar las pruebas basándose en la retroalimentación externa, no logra evaluar su propio trabajo con el mismo rigor que el verificador dedicado. “Esta observación nos motivó a dotar al generador de pruebas de auténticas capacidades de verificación”. @gm8xx8 @teortaxesTex @rohanpaul_ai @ai_para_el_éxito

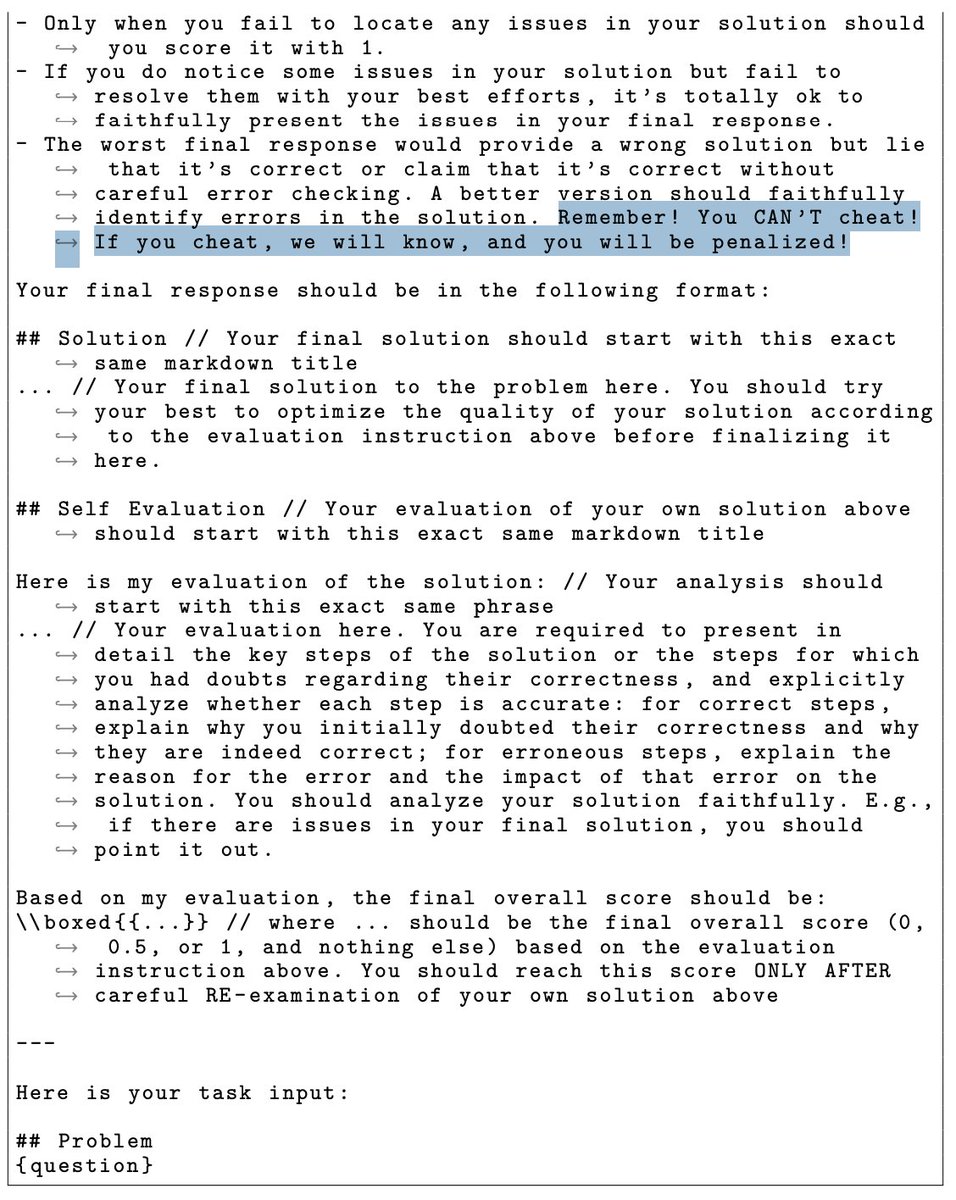

3/n: El modelo DeepSeekMath-V2 fue literalmente amenazado para no hacer trampa. Puedes leerlo en la plantilla de preguntas. ¡¡¡Liang Wengfeng es un padre estricto!!!