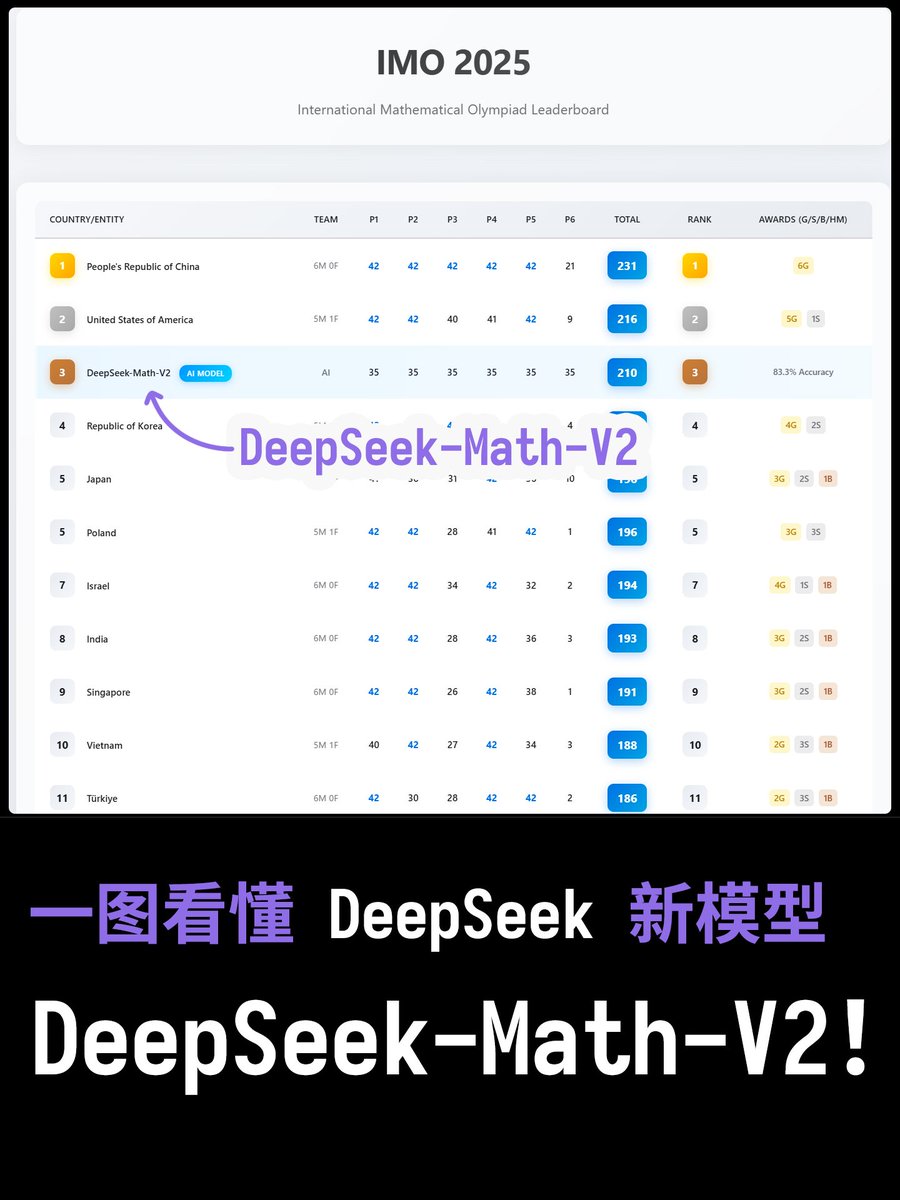

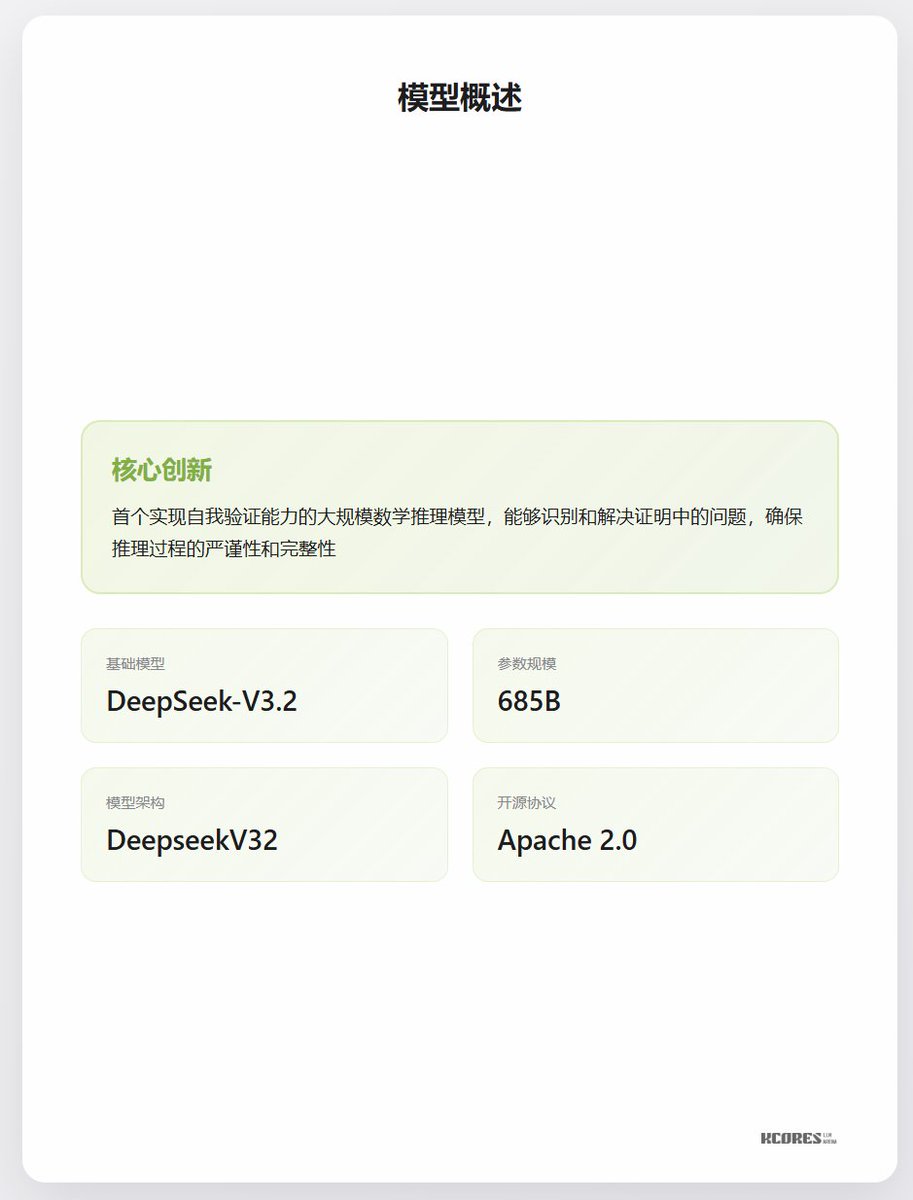

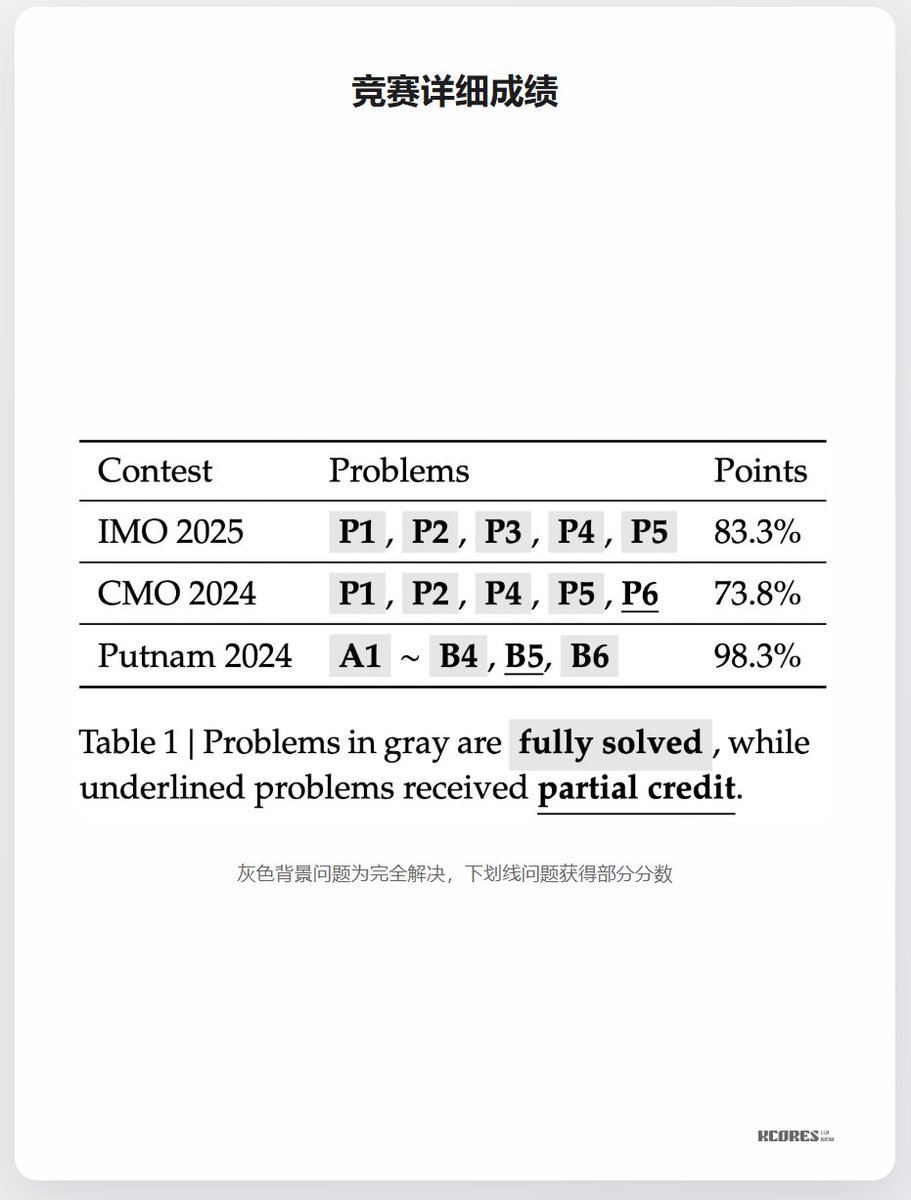

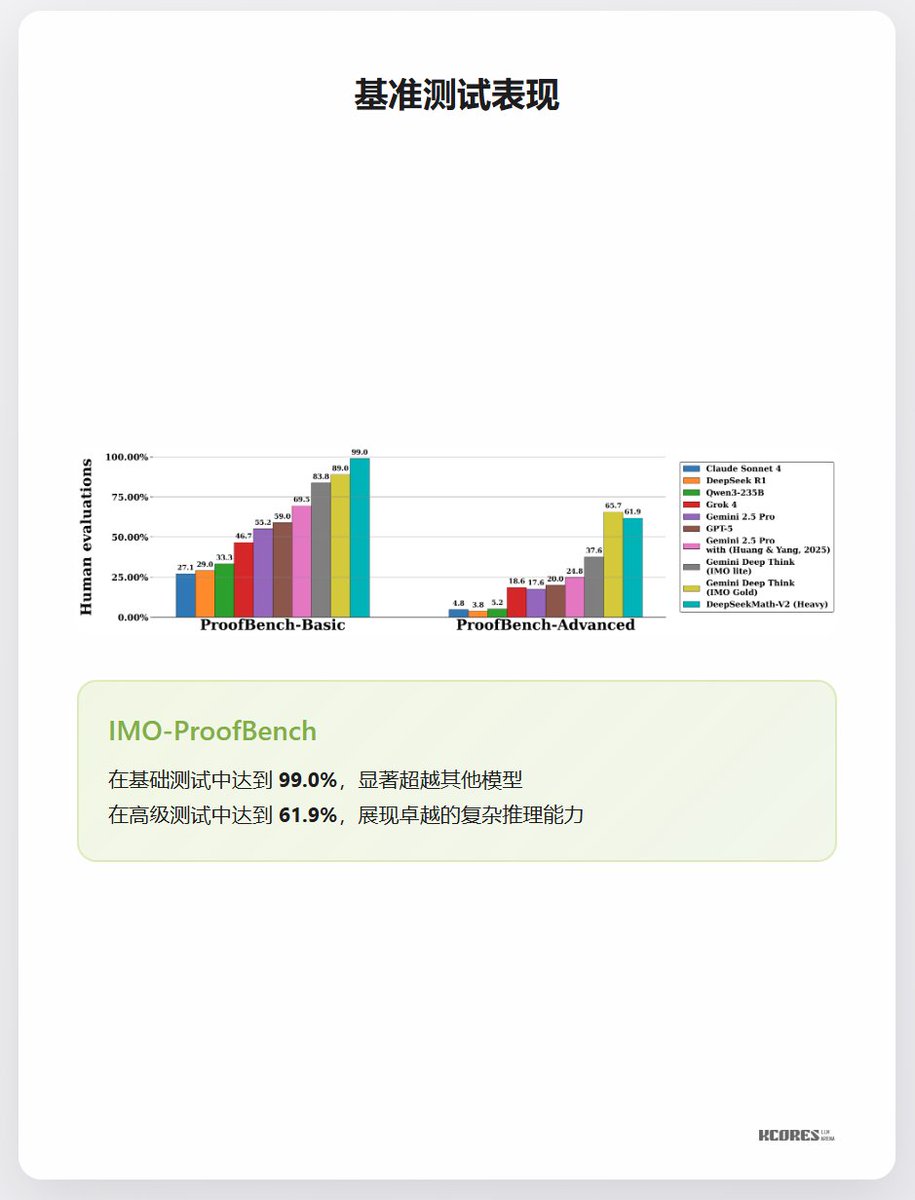

¡Una sola imagen para comprender el nuevo modelo DeepSeek, DeepSeek-Math-V2! ¡DeepSeek acaba de lanzar DeepSeek-Math-V2! Así es, este es un modelo específico de dominio, diseñado específicamente para el razonamiento matemático. Esta vez, se entrenó y afinó posteriormente con base en DeepSeek-V3.2, lo que significa que DeepSeek se ha adaptado completamente a la nueva arquitectura. En términos de rendimiento, obtuvo un 83,3 % en la OMI 2025 (Olimpiada Internacional de Matemáticas), alcanzando la medalla de oro. Superó ampliamente a ProofBench-Basic, con una puntuación del 99 %, superando a todos los demás modelos. ProofBench-Advanced quedó en segundo lugar, solo superado por Gemini Deep Think (una plataforma basada en agentes, no un modelo puro). Por cierto, mi país también obtuvo el primer lugar en la OMI 2025 este año. En ese entonces, mi puntuación promedio en DeepSeek-Math-V2 fue del 83,3 % en cada pregunta, y la puntuación debería ser de 210 puntos (de 252, 83,3 % de precisión), lo que nos colocaría entre Estados Unidos (216 puntos) y Corea del Sur (203 puntos), es decir, en tercer lugar.

Las puntuaciones se ajustaron a la clasificación de la OMI de este año.

Parámetros básicos

punto de referencia