Cada vez es más difícil obtener información de las cifras de referencia. En lugar de promedios, supongo que en un futuro (próximo) también nos interesará "argmax": ¿cuál es el MEJOR resultado que puede ofrecer un modelo? Al fin y al cabo, no necesitamos resolver PvsNP 10 de 10 veces; con una es suficiente 😅. Con esto en mente, permítanme contarles un poco más sobre el resultado LLM más impresionante que he visto.

Muchos de ustedes probablemente estén familiarizados con el modelo de apego preferencial (también conocido como Barabasi-Albert), que consiste en un proceso de grafo aleatorio creciente, donde cada nuevo nodo se une a uno existente con una probabilidad proporcional a sus grados. Esto es muy similar a cómo crece una red como X (las cuentas populares atraen cada vez a más seguidores). (hermoso gif de Igor Kortchemski)

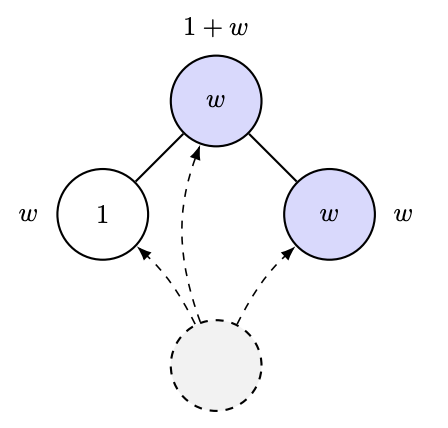

En 2012, Ramon y Comendant introdujeron en su problema abierto COLT una variante del proceso de vinculación preferencial, donde cada nodo nace con un parámetro de "atractivo", ya sea 1 o W > 1, y ahora la conexión con un nodo anterior es proporcional al atractivo total de sus vecinos. Es decir, si tienes muchos amigos atractivos, atraerás más conexiones. Supongo que simula el crecimiento de un laboratorio de investigación de IA o algo similar. La pregunta, muy simple, es: ¿se puede estimar W observando el grafo? [En realidad, preguntaron algo más cuantitativo, pero esa es la esencia de su pregunta].

Naturalmente, uno podría verse tentado a especular cosas como: quizás el crecimiento del nodo más popular dependa de W o algo similar, es decir, una estadística de grado. Bueno, al menos, de ser cierto, esto sería bastante delicado, ya que un artículo reciente de Ben-Hamou y Velona muestra que, en un modelo estrechamente relacionado (apego uniforme en lugar de apego preferencial, y la variación se basa en el apego a su propio nivel de atractivo con mayor probabilidad), ¡las estadísticas de grado NO PUEDEN determinar la diferencia! https://t.co/pdwr86OK5A

Ahora finalmente puedo afirmar lo que en mi opinión es el resultado LLM más impresionante que he visto: GPT-5 demostró el siguiente teorema, que da una forma cerrada para la fracción limitante de hojas en el proceso descrito anteriormente, lo que a su vez permite estimar W a partir de una observación de dicho gráfico.

La demostración (100% GPT-5) es sorprendentemente ingeniosa, ya que utiliza el análisis tipo Robbins Monro (¡es decir, SGD!) para controlar la convergencia de cantidades clave. Además, antes de analizar la demostración, le pedimos a GPT-5 que ejecutara una simulación y comprobara empíricamente la credibilidad de la fórmula.

Elaborar esa prueba, ejecutar la simulación y todo eso era lo que solía hacer en aproximadamente un mes. Ahora, esto se hizo en una tarde. Para aquellos interesados pueden encontrar la prueba completa y más detalles en el Capítuloarxiv.org/abs/2511.16072://t.co/IfotVApR3X. ¡Feliz día de Acción de Gracias!