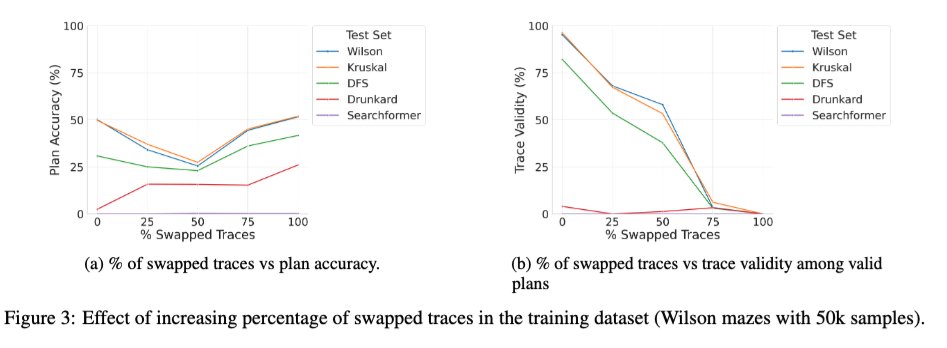

Acabamos de subir una versión ampliada del artículo "Más allá de la semántica" (nuestro estudio sistemático del papel de los tokens intermedios en los LRM) a arXiv, y puede que sea de interés para algunos de ustedes. 🧵 1/ Un nuevo estudio intrigante es el efecto de entrenar el transformador base con una combinación de trazas correctas e incorrectas. Observamos que, a medida que el porcentaje de trazas incorrectas (intercambiadas) durante el entrenamiento pasa de 0 a 100, la validez de las trazas de los modelos en el momento de la inferencia disminuye monótonamente (gráfico a la derecha abajo), como se esperaba, pero la precisión de la solución presenta una curva en U (gráfico a la izquierda). Esto sugiere que lo que parece importar es la consistencia de las trazas utilizadas durante el entrenamiento, más que su exactitud.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.