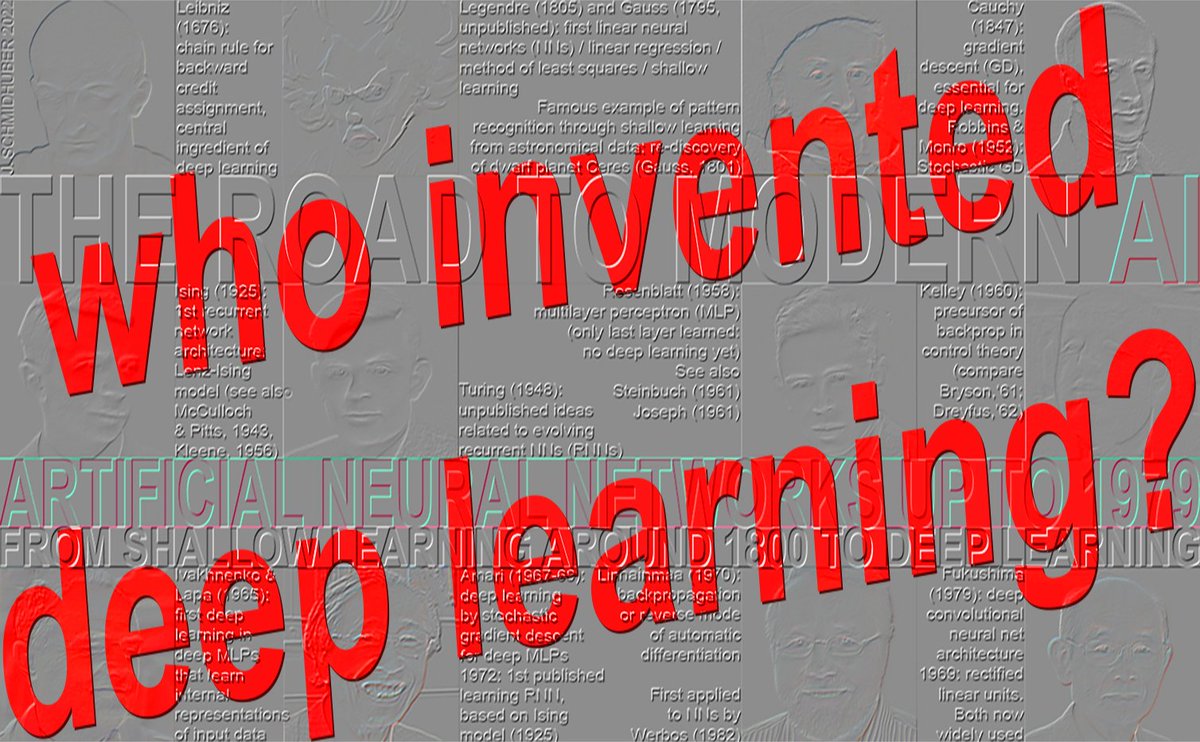

¿Quién inventó el aprendizajpeople.idsia.ch/~juergen/who-i…o/aJfpTfQSNk Cronología: 1965: primer aprendizaje profundo (Ivakhnenko y Lapa, 8 capas en 1971) 1967-68: aprendizaje profundo de extremo a extremo mediante descenso de gradiente estocástico (Amari, 5 capas) 1970: retropropagación (Linnainmaa, 1970) para NN (Werbos, 1982): rara vez >5 capas (década de 1980) 1991-93: preentrenamiento no supervisado para redes neuronales profundas (Schmidhuber, otros, más de 100 capas) 1991-2015: aprendizaje residual profundo (Hochreiter, otros, más de 100 capas) 1996-: aprendizaje profundo sin gradientes (más de 100 capas) ★ 1965: primer aprendizaje profundo (Ivakhnenko y Lapa, 8 capas en 1971) El aprendizaje exitoso en arquitecturas de redes de propagación hacia adelante profundas comenzó en 1965 en Ucrania (en aquel entonces la URSS) cuando Alexey Ivakhnenko y Valentin Lapa introdujeron los primeros algoritmos de aprendizaje generales y funcionales para perceptrones multicapa profundos (MLP) o redes neuronales de propagación hacia adelante (FNN) con muchas capas ocultas (que ya contenían las ahora populares puertas multiplicativas) [DEEP1-2][DL1-2][DLH][WHO5]. Un artículo de 1971 [DEEP2] describió una red de aprendizaje profundo con 8 capas, entrenada mediante su método altamente citado que todavía era popular en el nuevo milenio [DL2]. Dado un conjunto de entrenamiento de vectores de entrada con sus correspondientes vectores de salida objetivo, las capas se desarrollan y entrenan incrementalmente mediante análisis de regresión. En una fase de ajuste fino, las unidades ocultas superfluas se eliminan mediante regularización con la ayuda de un conjunto de validación independiente [DEEP2][DLH]. Esto simplifica la red y mejora su generalización con datos de prueba no detectados. El número de capas y unidades por capa se aprende de forma dependiente del problema. Esta es una generalización eficaz de la NN original de Gauss-Legendre de dos capas (1795-1805) [DLH]. Es decir, Ivakhnenko y sus colegas desarrollaron conexionismo con capas ocultas adaptativas dos décadas antes de que el nombre "conexionismo" se popularizara en la década de 1980. Al igual que las redes neuronales profundas posteriores, sus redes aprendieron a crear representaciones internas jerárquicas y distribuidas de los datos entrantes. No las denominó redes neuronales de aprendizaje profundo, pero eso era lo que eran. El trabajo pionero de Ivakhnenko fue plagiado repetidamente por investigadores que posteriormente compartieron un premio Turing [DLP][NOB]. Por ejemplo, la profundidad del entrenamiento por capas de Ivakhnenko de 1971 [DEEP2] fue comparable a la profundidad del entrenamiento por capas de Hinton y Bengio de 2006, publicado 35 años después [UN4][UN5], sin comparación con el trabajo original [NOB], realizado cuando la computación era millones de veces más costosa. De igual manera, LeCun et al. [LEC89] publicaron técnicas de poda de redes neuronales sin hacer referencia al trabajo original de Ivakhnenko sobre la poda de redes neuronales profundas. Incluso en sus estudios posteriores sobre aprendizaje profundo [DL3][DL3a], los galardonados no mencionaron los orígenes mismos del aprendizaje profundo [DLP][NOB]. Ivakhnenko y Lapa también demostraron que es posible aprender los pesos apropiados de las unidades ocultas utilizando únicamente información disponible localmente sin necesidad de un retroceso biológicamente improbable [BP4]. Seis décadas después, Hinton se atribuyó este logro [NOB25a]. ¿Cómo se comparan las redes de Ivakhnenko con redes multicapa de propagación hacia adelante incluso anteriores sin aprendizaje profundo? En 1958, Frank Rosenblatt estudió los perceptrones multicapa (MLP) [R58]. Sus MLP tenían una primera capa sin aprendizaje con pesos aleatorios y una capa de salida adaptativa. Esto aún no era aprendizaje profundo, ya que solo la última capa aprendía [DL1]. Karl Steinbuch [ST61-95] y Roger David Joseph [R61] también analizaron los MLP en 1961. Véase también el Pandemonium multicapa de Oliver Selfridge [SE59] (1959). En 1962, Rosenblatt et al. incluso escribieron sobre "errores de retropropagación" en un MLP con una capa oculta [R62], siguiendo las ideas preliminares de Joseph de 1961 sobre el entrenamiento de unidades ocultas [R61], pero Joseph y Rosenblatt no contaban con un algoritmo de aprendizaje profundo funcional para MLP profundos. Lo que ahora se llama retropropagación es bastante diferente y fue publicado por primera vez en 1970 por Seppo Linnainmaa [BP1-4]. ¿Por qué surgió el aprendizaje profundo en la URSS a mediados de la década de 1960? En aquel entonces, el país lideraba importantes campos de la ciencia y la tecnología, sobre todo en el espacio: el primer satélite (1957), el primer objeto artificial en un cuerpo celeste (1959), el primer hombre en el espacio (1961), la primera mujer en el espacio (1962), el primer robot que aterrizó en un cuerpo celeste (1965) y el primer robot en otro planeta (1970). La URSS también detonó la bomba más grande de la historia (1961) y fue cuna de numerosos matemáticos destacados, con financiación suficiente para la investigación matemática innovadora, cuya enorme trascendencia se manifestaría solo décadas después. Las demás secciones mencionadas anteriormente (1967, 1970, 1991-93, 1991-2015, 1996) se abordan en [WHO5]: ¿Quién inventó el aprendizaje profundo? Nota técnica IDSIA-16-25, IDSIA, noviembre de 2025. REFERENCIAS SELECCIONADAS (muchas referencias adicionales en [WHO5] - ver enlace arriba): [BP1] S. Linnainmaa. La representación del error de redondeo acumulativo de un algoritmo como una expansión de Taylor de los errores de redondeo locales. Tesis de maestría (en finlandés), Univ. Helsinki, 1970. Véanse los capítulos 6-7 y el código FORTRAN en las páginas 58-60. Véase también BIT 16, 146-160, 1976. Enlace. Primera publicación sobre retropropagación moderna, también conocida como el modo inverso de diferenciación automática. [BP4] J. Schmidhuber (2014). ¿Quién inventó la retropropagación? [BPA] H. J. Kelley. Teoría de gradientes de trayectorias de vuelo óptimas. ARS Journal, vol. 30, n.º 10, págs. 947-954, 1960. Precursor de la retropropagación moderna [BP1-4]. [DEEP1] Ivakhnenko, AG y Lapa, VG (1965). Dispositivos de predicción cibernética. CCM Information Corporation. Primeros dispositivos de aprendizaje profundo funcionales con múltiples capas, que aprenden representaciones internas. [DEEP1a] Ivakhnenko, Alexey Grigorevich. El método de grupo para el manejo de datos; un rival del método de aproximación estocástica. Soviet Automatic Control 13 (1968): 43-55. [DEEP2] Ivakhnenko, AG (1971). Teoría polinómica de sistemas complejos. IEEE Transactions on Systems, Man and Cybernetics, (4):364-378. [DL1] J. Schmidhuber, 2015. Aprendizaje profundo en redes neuronales: Una visión general. Neural Networks, 61, 85-117. Obtuvo el primer Premio al Mejor Artículo otorgado por la revista Neural Networks, fundada en 1988. [DL2] J. Schmidhuber, 2015. Aprendizaje profundo. Scholarpedia, 10(11):32832. [DL3] Y. LeCun, Y. Bengio, G. Hinton (2015). Aprendizaje profundo. Nature 521, 436-444. Un estudio sobre aprendizaje profundo que no menciona los trabajos pioneros [DLP][NOB]. [DL3a] Y. Bengio, Y. LeCun, G. Hinton (2021). Conferencia Turing: Aprendizaje profundo para IA. Comunicaciones de la ACM, julio de 2021. Otra "encuesta" sobre aprendizaje profundo que no menciona los trabajos pioneros en este campo [DLP][NOB]. [DLH] J. Schmidhuber. Historia comentada de la IA moderna y el aprendizaje profundo. Informe técnico IDSIA-22-22, IDSIA, Lugano, Suiza, 2022. Preimpresión arXiv:2212.11279. [DLP] J. Schmidhuber. Cómo tres ganadores del premio Turing republicaron métodos e ideas clave cuyos creadores no reconocieron. Informe Técnico IDSIA-23-23, Swiss AI Lab IDSIA, 2023. [GD'] C. Lemarechal. Cauchy y el método del gradiente. Doc Math Extra, págs. 251-254, 2012. [GD''] J. Hadamard. Memoire sur le probleme d'analyse relatif a Vequilibre des plaques elastiques encastrees. Mémoires presentes par divers savants estrangers à l'Academie des Sciences de l'Institut de France, 33, 1908. [GDa] YZ Tsypkin (1966). Adaptación, entrenamiento y autoorganización de sistemas de control automático, Avtomatika I Telemekhanika, 27, 23-61. Sobre el aprendizaje en línea basado en descenso de gradientes para sistemas no lineales. [GDb] YZ Tsypkin (1971). Adaptación y aprendizaje en sistemas automáticos, Academic Press, 1971. Sobre el aprendizaje en línea basado en descenso de gradiente para sistemas no lineales. [GD1] SI Amari (1967). Una teoría del clasificador de patrones adaptativo, IEEE Trans, EC-16, 279-307 (versión japonesa publicada en 1965). Probablemente el primer artículo sobre el uso del descenso de gradiente estocástico [STO51-52] para el aprendizaje en redes neuronales multicapa (sin especificar el método específico de descenso de gradiente, ahora conocido como modo inverso de diferenciación automática o retropropagación [BP1]). [GD2] SI Amari (1968). Teoría de la Información: Teoría Geométrica de la Información, Kyoritsu Publ., 1968 (en japonés, véanse las páginas 119-120). Contiene resultados de simulación por computadora para una red de cinco capas (con dos capas modificables) que aprende representaciones internas para clasificar clases de patrones no linealmente separables. [GD2a] S. Saito (1967). Tesis de maestría, Escuela de Ingeniería, Universidad de Kyushu, Japón. Implementación del método de descenso de gradiente estocástico de Amari de 1967 para perceptrones multicapa [GD1]. (S. Amari, comunicación personal, 2021). [NOB] J. Schmidhuber. Un Premio Nobel por Plagio. Informe Técnico IDSIA-24-24 (7 de diciembre de 2024, actualizado en octubre de 2025). [NOB25a] G. Hinton. Conferencia Nobel: Máquinas de Boltzmann. Rev. Mod. Phys. 97, 030502, 25 de agosto de 2025. Una de las muchas afirmaciones problemáticas de esta conferencia es la siguiente: «Las máquinas de Boltzmann ya no se utilizan, pero fueron históricamente importantes [...] En la década de 1980, demostraron que era posible aprender pesos apropiados para neuronas ocultas utilizando únicamente información local disponible sin necesidad de un paso hacia atrás biológicamente improbable». De nuevo, Hinton omite mencionar a Ivakhnenko, quien había demostrado esto dos décadas antes, en la década de 1960 [DEEP1-2]. [WHO5] J. Schmidhuber (AI Blog, 2025). ¿Quién inventó el aprendizaje profundo? Nota técnica IDSIA-16-25, IDSIA, noviembre de 2025. Véase el enlace anterior.

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.