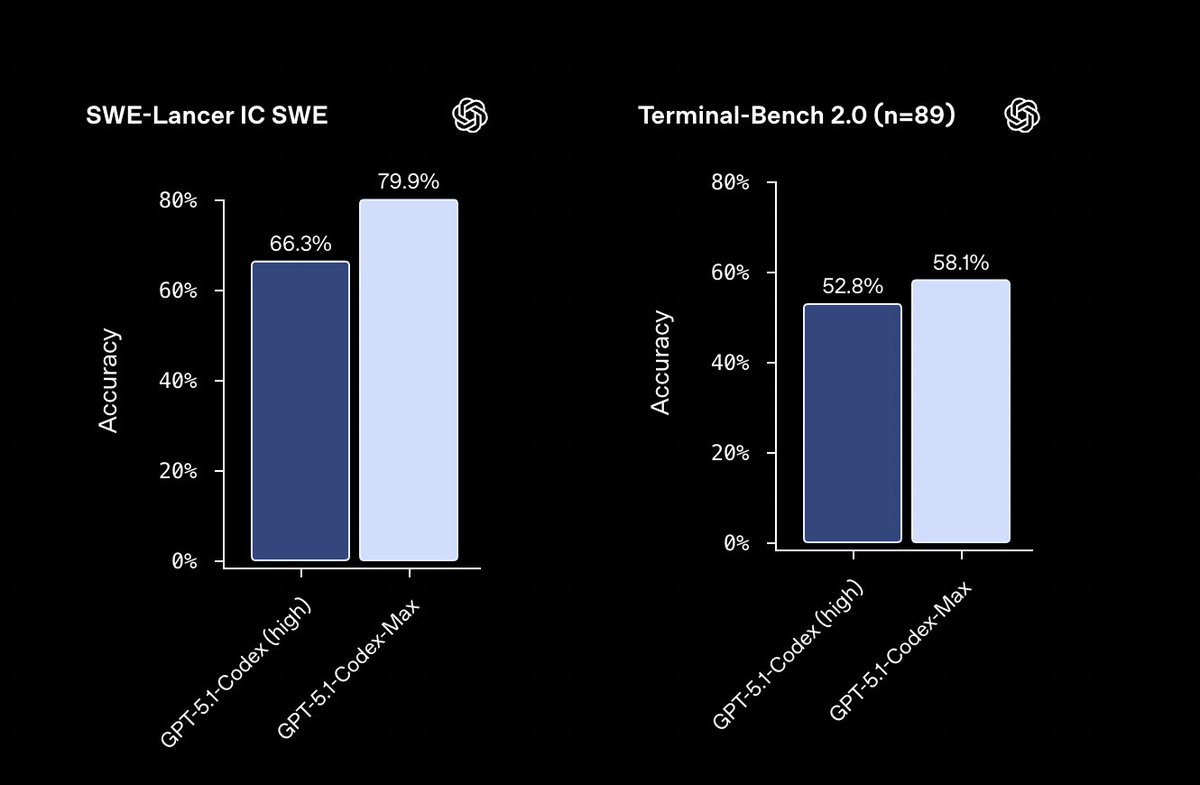

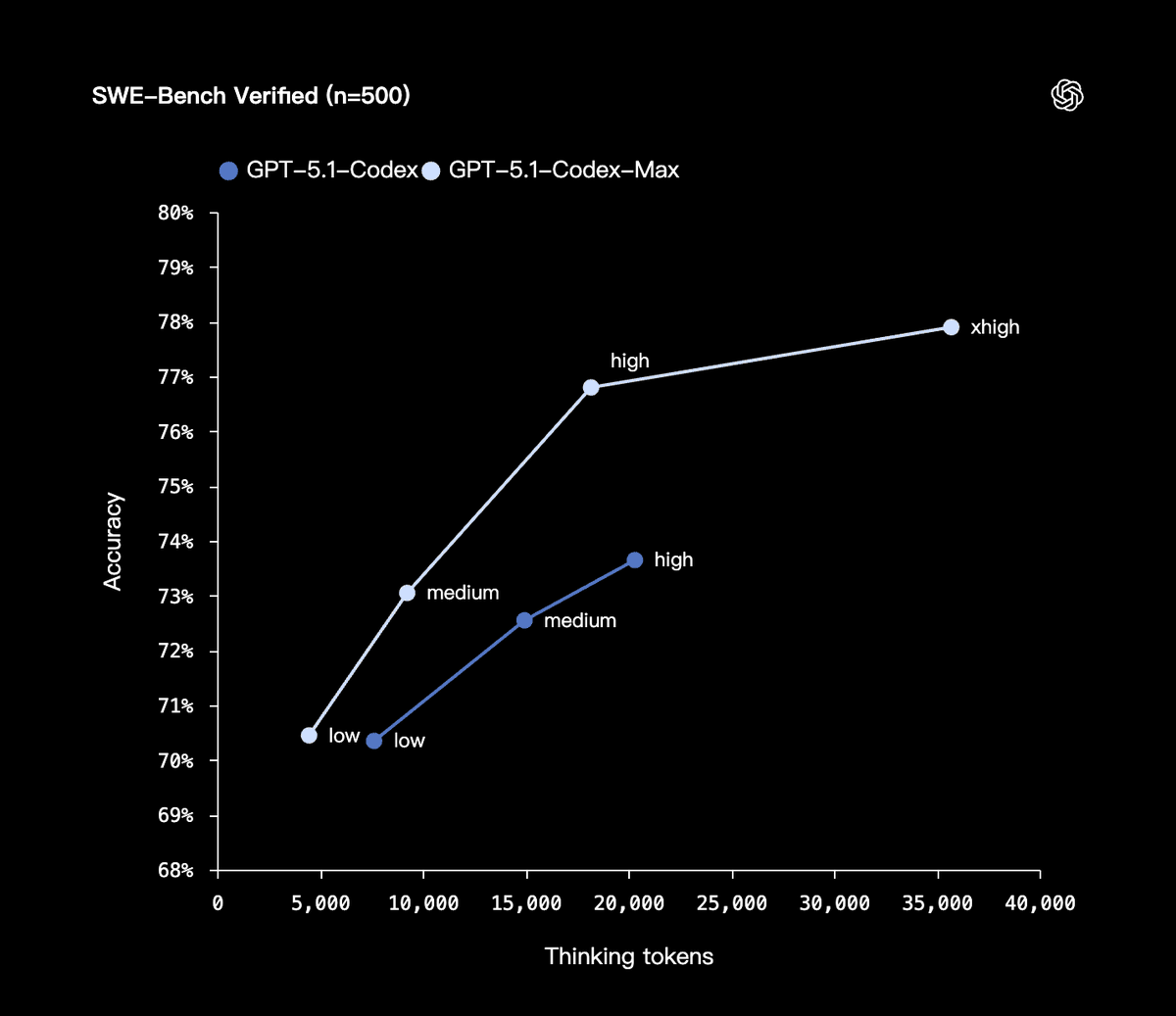

OpenAI ha lanzado su nuevo modelo de código, GPT-5.1-Codex-Max, diseñado para abordar bases de código extremadamente grandes y ciclos de desarrollo largos, haciéndolo más rápido y eficiente en el uso de tokens, completando docenas de horas de trabajo de una sola vez. La tasa de verificación de SWE-bench alcanzó el 77,9%, un 4% más que la generación anterior; Pensar en tokens supone un ahorro del 30% en comparación con otros tokens de la misma calidad. Codex-Max puede comprender tareas complejas y planificarlas, ejecutarlas y revisarlas de forma iterativa de manera autónoma. Utiliza un nuevo mecanismo de compresión que puede optimizar el contexto de millones de tokens y crear espacio para seguir escribiendo, garantizando una iteración continua durante 24 horas sin pérdida de información. Internamente, reconstruyó de forma independiente todo el repositorio de Codex CLI, funcionando en bucle durante 24 horas, probando los fallos, corrigiéndolos y volviéndolos a ejecutar antes de entregarlo finalmente. GPT-5.1-Codex-Max reemplazará a GPT-5.1-Codex y se convertirá en el modelo predeterminado en la interfaz Codex. #openai #GPTCodexMax

Cargando el detalle del hilo

Obteniendo los tweets originales de X para ofrecer una lectura limpia.

Esto suele tardar solo unos segundos.