¡Nunca bloquees la GPU! En una nueva publicación del blog @modal, analizamos una clase importante de ineficiencia en la inferencia de IA: la sobrecarga del host. Incluimos tres casos en los que trabajamos con @sgl_project para reducir la sobrecarga del modal.com/blog/host-over…de la GPU. Cada microsegundo cuenta. https://t.co/ZeumrZpSKE

Para la inferencia, me gusta pensar en la GPU como un gran barco y en la CPU como un navegante. El navegante debe indicarle al barco adónde ir. Si el barco se detiene alguna vez, esperando a que el navegante diga qué hacer a continuación, ¡eso es malo! Se están desperdiciando recursos y tiempo.

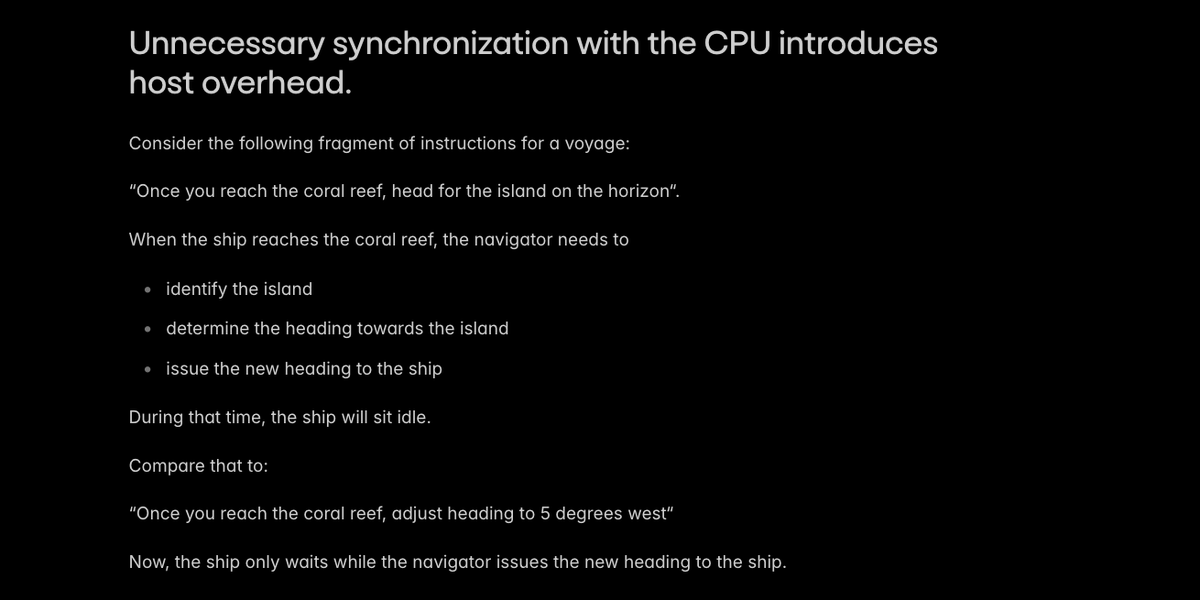

La principal causa de la sobrecarga del host en la inferencia de IA es la sincronización innecesaria con la CPU, lo que hace que el sistema espere al navegador.

Los motores de producción como @sgl_project evitan los casos más obvios de sincronización host/dispositivo. Encontramos dos casos especiales donde un poco de ingenio podría evitar una sincronización: - Construyendo algunas incrustaciones de posición en el dispositivo - Recalcular algunas longitudes de página de la caché KV en el host

Relacionesgithub.com/sgl-project/sg…/github.com/sgl-project/sg…://t.co/Sc340PbB2F

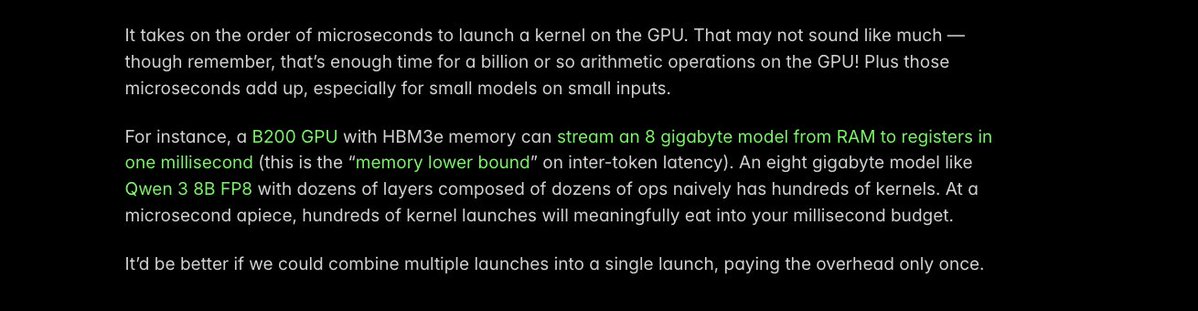

Otro truco clave para reducir la sobrecarga del host es _fusionar_ kernels: convertir varios lanzamientos de kernels de GPU separados en uno solo. El tiempo de procesamiento de cada lanzamiento es de apenas un microsegundo, ¡pero cada microsegundo cuenta!

Identificamos una operación específica que tenía una gran sobrecarga de lanzamiento del kernel en VLM más pequeños, aquellos de los que estamos viendo un despliegue mucho mayor (gracias a @Alibaba_Qwen). Así que utilizamos el compilador @PyTorch para fusionar automáticamente los kernels, reduciendo el tiempo de ejecución de 40 µs a 5 µs.

Más detalles en estagithub.com/sgl-project/sg…//t.co/gvEqTgdIth

La compilación con Torch es excelente para obtener mejoras rápidas en la latencia de inferencia en general. Hemos modal.com/blog/flux-3x-f…: https://t.co/MN072QDXzz

¡Aún quedan muchos microsegundos por recortar y muchas GPU por liberar de las ataduras del código de CPU no optimizado! Pero el equipo de @modal está entusiasmado por haber logrado ya avances que ayudan a nuestros clientes a ofrecer aplicaciones de IA imodal.com/blog/host-over…log aquí: https://t.co/ZeumrZqqAc