Se ha añadido un nuevo miembro al modelo grande de código abierto desarrollado a nivel nacional. Hoy mismo, Baidu ha liberado el código fuente de otro modelo de pensamiento multimodal: ERNIE-4.5-VL-28B-A3B-Thinking. Con solo 3 mil millones de parámetros de activación, sus capacidades de comprensión y razonamiento multimodal se acercan a las de los modelos GPT-5-High y Gemini-2.5-Pro. Lo más destacable esta vez es su capacidad de "pensamiento visual", que permite a los usuarios acercar y alejar activamente las imágenes, observar cuidadosamente los detalles y luego pensar en preguntas y responderlas. Igual que las personas, cuando ven una imagen, la piensan, la entienden y luego le cuentan a todo el mundo lo que contiene. A continuación se presentan los casos de prueba oficiales. Veamos:

Un meme clásico que representa la carga de trabajo real de los trabajadores (Figura 1). El modelo puede comprender el humor de la imagen y explica en detalle cómo la imagen toca con precisión los puntos débiles de los trabajadores modernos (Figura 2).

Una foto de un pastel de luna caducado, con la fecha de caducidad de producción borrosa (Figura 1). Incluso si una persona amplía la foto al máximo, apenas puede ver claramente, pero aún así puede ver correctamente que "el pastel de luna ha caducado" (Figura 2).

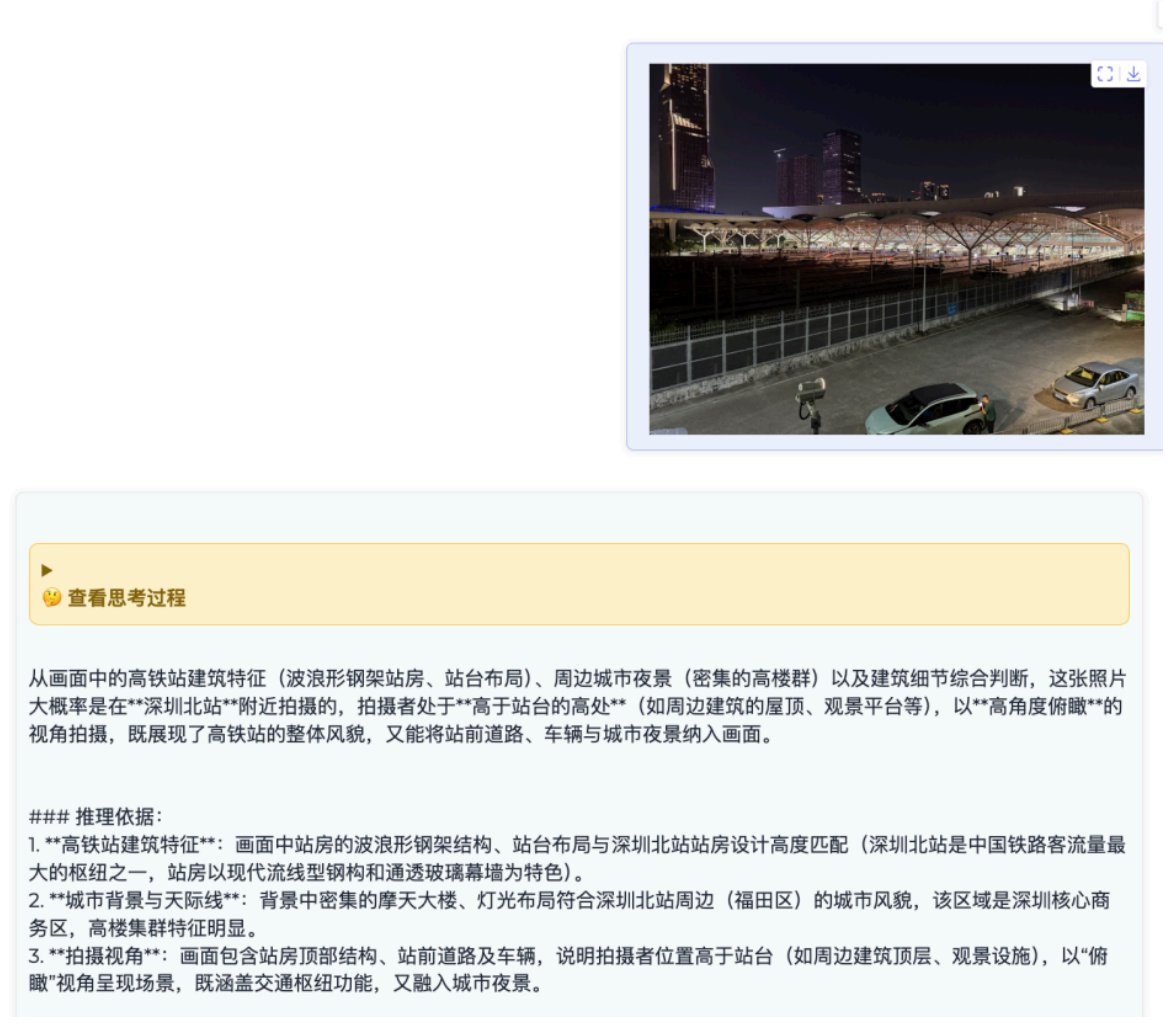

Además, una fotografía de una vista nocturna tomada en el norte de Shenzhen (Figura 1). Sin ninguna indicación, puede determinar la ubicación específica de disparo basándose en las características arquitectónicas de la imagen (Figura 2). Y se basa en razonamientos y pruebas sólidas, lo cual es realmente impresionante.

En general, la capacidad de "pensamiento visual" introducida por este modehuggingface.co/baidu/ERNIE-4.…e fuerte; parece ser capaz de ver y comprender la información de las imágenes. Todavía no hay ninguna demostración en línea disponible, pero el modelo es de código abierto. Descarga el modelo: https://t.co/WOYawrwuZL